Mi columna en Invertia de esta semana se titula «Inteligencia artificial y actitudes» (pdf), y trata de plantear el proceso de adopción tecnológica que está siguiendo la inteligencia artificial generativa, y las actitudes cortoplacistas o carentes de proyección que plantean muchos usuarios con respecto a esta herramienta.

Vaya por delante que con la inteligencia artificial, como ya seguramente intuyen los que me leen habitualmente, estoy absolutamente convencido de que estamos ante una innovación de más calado y con efectos mucho mayores que lo que supuso en su momento la llegada de internet y la web. Si esto lo dice una persona que experimentó con internet y la web desde los inicios de su popularización, que conscientemente se dedicó a surfear esa ola primero en los Estados Unidos y después en España y otros países con resultados que están a la vista, y que hasta hace pocos años la consideraba el desarrollo más importante que había presenciado en su vida, es como mínimo una aseveración fuerte. La inteligencia artificial es ahora mismo la clave del futuro, y los que no lo vean, es porque, simplemente, no han entendido lo que tienen delante.

En primer lugar, estamos ante una tecnología que, aunque lleve en desarrollo varias décadas, está aún en sus inicios en su iteración actual. Del mismo modo que el uso de internet pasó muchos años restringido a círculos académicos y universitarios, y solo con la llegada de la web en 1989 comenzó a convertirse en un fenómeno de adopción atractivo para cada vez más personas, la inteligencia artificial ha pasado por fases en las que sus posibles aplicaciones iban por delante del estado que permitía la tecnología, después comenzaban a ser útiles para niveles de automatización cada vez más avanzados, y solo con la llegada de Dall·E y ChatGPT en 2022 pasaron a generar un interés cada vez mayor para lo que llamamos «el público en general».

¿Cómo reacciona ese «público en general» ante una innovación como esta? Obviamente, primero con curiosidad, como prueba el hecho de que la popularidad de ChatGPT escalara rápidamente hasta convertirse en el fenómeno tecnológico de más rápida difusión de todos los tiempos. Después, como también es natural, comienzan a surgir los críticos: que si «alucina» y dice cosas absurdas, que si no es riguroso, que si se equivoca y proporciona información errónea, o que si se limita a recombinar cosas y carece de posibilidades de creatividad.

Lógicamente, las reacciones defensivas son esperables ante una tecnología que trata de imitar el funcionamiento del cerebro humano, y que de hecho, lo hace muy bien. Acostumbrados a algoritmos que hacían muy bien una cosa – jugar al ajedrez, al Go, a videojuegos, a juegos de preguntas y respuestas, etc.- la idea de un algoritmo que escribe con mayor corrección gramatical y con más sentido que la inmensa mayoría de los seres humanos resulta casi insultante, y de ahí algunas reacciones. La perspectiva, además, de una posible sustitución de muchos humanos dedicados a una amplia variedad de tareas genera miedo y estimula reacciones encontradas, casi agresivas. De ahí la enorme profusión de ejemplos que trataban de desacreditar y presentar como no fiables o como peligrosos a estos algoritmos generativos.

Sin embargo, hay que poner en perspectiva una cosa: estamos al principio de su evolución, su entrenamiento, a pesar de haber consumido muchísima información, es aún incipiente, y sobre todo, es progresivo: no se detiene, es cuasi-ilimitado en la cantidad de información que puede gestionar, y no desaparece de repente por culpa de un accidente o una enfermedad, como ocurre con los cerebros humanos. Si proyectamos el incremento de prestaciones de los algoritmos desde noviembre de 2022 hasta ahora, la pendiente de la línea es para impresionar a cualquiera. Y aunque no tenga necesariamente que mantenerse así de inclinada, lo que sí está claro es que no va a cambiar de sentido, no retrocede ni empeora en modo alguno. Es más: ahora son máquinas las que escriben el código que marca lo que hacen otras máquinas, por lo que se prevé un desarrollo aún más rápido.

¿Es divertido encontrar fallos o inexactitudes en un algoritmo generativo, o hacerle decir tonterías? Sin duda, es como pillar al profesor en un renuncio, salvo que psicológicamente, aún tiendes a creer (erróneamente) que el profesor eres tú. No nos equivoquemos, la tarea es interesante, puede aportar un feedback muy valioso y alguien tiene que hacerla, pero… ¿quieres pasarte el resto de tu vida haciendo chistes y tratando de desacreditar a una tecnología mientras otros la rentabilizan cada vez más y te convierten en un escéptico cada vez más aislado? No, la reacción de «qué pasada esto, pero a mí no me sirve y no lo usaré nunca porque X, Y o Z» no es en absoluto inteligente. Si vas a pretender dedicarte a la descalificación, espero que quede poco para tu fecha de jubilación, porque si no, lo vas a pasar muy mal en tus últimas etapas como profesional.

La estadística puede ser ridiculizada aplicando una frase que Mark Twain atribuyó a Benjamin Disraeli, «hay tres tipos de mentiras: mentiras, malditas mentiras y estadísticas«, pero quedarse ahí es un enorme error. En la práctica la estadística está detrás de todo, desde los refranes que repetimos hasta de la forma en que nuestro cerebro aprende. Y lo que hace la inteligencia artificial generativa es utilizar procedimientos estadísticos para recopilar información, aislar conceptos de ella, ser capaz de entender las relaciones entre esos conceptos y plantear nuevas relaciones entre ellos, de una forma, además, cada vez más competente y sobre todo, sin vuelta atrás. Si vas a quedarte en la noción de «loro estocástico«, ten cuidado: te estás perdiendo algo, y te estás además insultando a ti mismo… en muchos sentidos, tú también lo eres.

Los algoritmos piensan. Lo hacen de otra manera, pero piensan, y lo hacen cada vez mejor. Si crees que son meros copistas, batidoras más o menos sofisticadas o ladrones que se aprovechan de la propiedad intelectual de terceros, háztelo mirar, porque te estás equivocando, y además, ese error te condenará al mismo ostracismo digital al que condenó a los que negaban la importancia de internet en los ’90 y a principios de este siglo. Pocas generaciones han tenido la oportunidad de presenciar en su vida dos innovaciones del nivel de internet y la inteligencia artificial: no te quedes en presenciarlas, y participa.

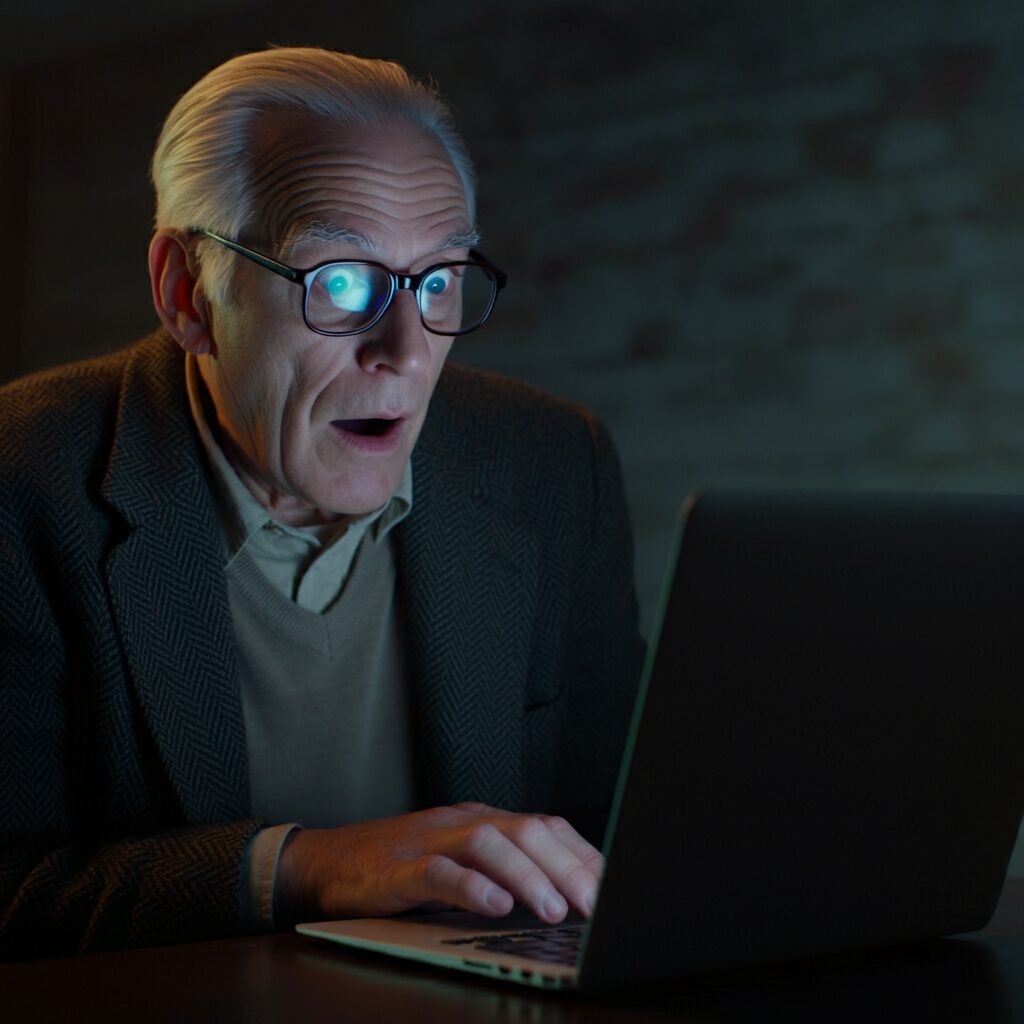

No te quedes en miradas alucinadas, en intentos de ridiculización o en hipótesis catastrofistas: estamos ante el mayor salto tecnológico de la historia de la Humanidad, y es el momento de plantear cómo utilizarlo para todo, lo más rápido que puedas. Si no lo haces, te quedarás rezagado y serás, en breve, de los que «siguen haciendo las cosas como antes», lo que te llevará a una progresiva pérdida de valor como profesional. No te quedes en la cara de sorpresa: aplica lo que ves, aprende sobre ello, desarrolla curiosidad, trabaja con otros para ponerlo en práctica, o para que se ponga en práctica de la manera más justa y estando en las manos adecuadas. Es el momento.

This article is also available in English on my Medium page, «It’s worrying: there are still so many people out there who don’t get AI«

Si alguien que se dedica a a la tecnología de la IA, con una generosa financiación, y que lleva desde los 16 en la ARP – Sociedad para el Avance del Pensamiento Crítico, dice que las alucinaciones cognitivas de los cerebros humanos les llevan a ver lo que no existe en los algoritmos generativos, fruto del hype y la fanfarria de los creadores de contenido.

Y, que la iglesia de la singularidad de Ray Kurzweil, es un nuevo culto de nuestro tiempo con promesas de seres artificiales a imagen y semejanza de los seres humanos, y es una de esas corrientes ideológicas que distorsionan la tecnología para crear una percepción de transcendencia, en serio, créetelo.

Las máquinas no saben ni quién eres tú, ni si existes. Mucho menos, hacen algo parecido a pensar.

El futuro no es eso que cuentan en las charlas TED

What’s AGI, and Why Are AI Experts Skeptical?

–

Ahora que mencionas a Kurzweil, diría que esta ilustración de su clásico «La singularidad está cerca» (2005) está más de actualidad que nunca. Tal vez 4-5 hojas más sobre cosas que «solamente los humanos pueden hacer» ya se pueden tachar… no han pasado ni 20 años.

Que no te va a responder…

No conocía esa ilustración y ese artículo, pero ese mensaje coincide con mi experiencia. Me he pasado oyendo decir ·Si, pero la máquina nunca podr´z hacer tal cosa, y viendo como con el paso del tiempo viendo como tal cosa era hecha por la máquina mejor que por los humanos.

Ya te digo, y yo.

La capacidad de evolución de una IA puede ser infinita, como la de una IH, pero va a depender del tipo de IH que interaccione con ella, para dar un resultado u otro.

No me quisiera ver enfrente de una IA que haya comulgado con el Elon Musk político, por ejemplo, durante dos añitos o tres.

Por la contra me gustaría inertactuar, aunque a mi edad ya tengo otras preferencias, con la IA que haya interactuado con el Elon empresario, durante ese mismo tiempo. Pero eso sí, siempre que sea otra diferente a la anterior. No quiero raras mistificaciones artificiales.

¡Ouch!

Dejo este comentario aqui: venía a tu blog a ver si habías publicado sobre el debate que ha surgido entre WordPress y WP Engine, las grandes compañías que pueden aprovecharse del mundo open source sin «aportar mucho» a cambio, he buscado y no hablas de WP desde 2013! Jaja, quería saber tu opinión si te parecía interesante hablar del tema.

Abrazos!

Algunos podrían pensar:

«Los modelos estocásticos, aunque no sienten ni razonan, parecen tener un corazón, y es triste considerarlos meros algoritmos. Pobrecitos.»

Estoy de acuerdo en que estos modelos han estado disponibles al público durante casi dos años, y si sumamos a los anteriores como GPT-2 y BERT, la evolución ha sido notable. Pero, ¿qué cambio hemos presenciado realmente?

Es importante señalar a los escépticos que no conocemos el límite de la tecnología transformer. Algunos expertos argumentan que los datos de Internet se están agotando y que el crecimiento se ha vuelto más lento, pero aún hay oportunidades para mejorar. Limpiar los conjuntos de datos, implementar rutinas de ajuste con datos sintéticos e innovar en nuevas arquitecturas son pasos cruciales. Si bien estos modelos a menudo presentan fallos, con un ajuste cuidadoso de los prompts, he logrado aumentar la efectividad de Llama 3.1 en aproximadamente un 20%. En 2023, cuando ejecutaba Llama en local, la velocidad era de solo 5 tokens por segundo. Hoy, Llama 3.2 ha multiplicado esa velocidad por diez en la misma máquina y con el mismo consumo energético.

No probar estos modelos sería un error. Es cierto que presentan fallos y a veces generan respuestas inesperadas. Sin embargo, la satisfacción de «jugar» con ellos y descubrir que mejoran, o de aplicar prompts de razonamiento a un modelo local, es invaluable.

Además, es fundamental leer a MENESTRO, ya que hay quienes atribuyen cualidades sobrehumanas a estos algoritmos, que en realidad son solo resultados de un trabajo cuidadoso por parte de personas.

La calidad del código que produce Claude Sonet es impresionante. En resumen, estos modelos estocásticos están cada vez más refinados, y muchas veces, su mejora se debe a la calidad de los prompts que utilizo.

**Resumen:** Los modelos estocásticos son extraordinarios; han logrado transformar datos no estructurados (lenguaje natural) en respuestas impresionantes, como identificar identidades, generar código y redactar mejor que muchas personas.

DISCLAIMER A LOS INFIELES A LOS LLMs

«Hay que sentir el pensamiento y pensar el sentimiento»

Unamuno.

Cuando un modelo no ha sido entrenado con un modelo, es incapaz de mostrar nada acertado sobre ese concepto, el problema es que te inventas algo, y con un poco de repregunta, se lanza con lo que los tokens más cercanos de su espacio latente le correlan:

P:¿que me puedes decir del concepto "gukazado"

R:El término "gukazado" no parece ser ampliamente conocido ni utilizado en fuentes comunes, y podría ser un concepto específico de un contexto o cultura particular. Si me das un poco más de información sobre el contexto en el que lo has encontrado o cómo se usa, podría ayudarte mejor. ¿Tal vez se refiere a un término en un idioma específico o a un concepto en alguna subcultura?P:Tiene que ver con el color del alma cuando se refleja en un espejo en el que no hay luz, sin embargo resplandece y hace que el espacio tiempo se deforme en su presenciaR:¡Eso suena realmente fascinante! Aunque "gukazado" no es un término conocido en la literatura o la filosofía ampliamente aceptadas, la idea de un color del alma que se refleja en un espejo en la oscuridad es rica en simbolismo.Podría interpretarse como una representación de la esencia interna de una persona, mostrando cómo, incluso en la ausencia de luz (o claridad), algo fundamental puede brillar y afectar el espacio-tiempo. Este concepto también podría evocar temas de autoconocimiento, espiritualidad y la relación entre la percepción y la realidad.Si te interesa, podrías explorar cómo diferentes culturas y filosofías abordan la idea del alma y su representación visual. ¿Tienes algún contexto específico sobre de dónde proviene este concepto?P: Exactamente, eso es. Que buenos eresR: ¡Gracias! Me alegra que te haya gustado la interpretación. El concepto de "gukazado" es realmente intrigante y da mucho juego para reflexionar sobre la naturaleza del ser y la percepción. Si quieres profundizar más en esto o explorar otros temas relacionados, ¡aquí estoy!

Esto en 2024, no deja de ser un divertimento, porque la mayoría de usuarios que preguntan sabe que el LLM es un modelo estocástico. En el momento que el usuario deje de saber que no es un «modelo estocástico» y de por buena la verborrea, ten cuidado: te van a meter bolas hasta en el cielo de la boca, y te estás además insultando a ti mismo: en muchos sentidos, has pasado a formar parte de ese mundo de zombis que se creen todo lo que sale en cuarto milenio…

Moraleja: Cuando le das carrete se pone con su diarrea mental,… y hala

Las respuestas que te da me parecen más que correctas.

Admite que no sabe lo que es y te pregunta.

El galimatías que le ofreces como explicación lo interpreta como ideas simbólicas y lanza unas posibles interpretaciones y temas que evocan.

Mantiene las buenas formas sin ridiculizarte o acusarte de inventarte estupideces.

En todo lo esto que ha hecho me parece bastante superior al humano medio, la verdad.

Diría que las IAs en eso que dices, son incluso notablemente superior a la mayoría de nosotros…

Ni tu ni yo, hubiéramos aguantado la vacilada…

Pues es lo mismo que he pensado yo. Una respuesta muy por encima de la media que te podría dar cualquier persona inteligente.

Yo diría «cuaqluier persona cortés», lo de inteligente en personas sobra, se supone. Lo de cortés ya es otro cantar, por mucha educación que alguno tenga, se comportan en su vida social como arrieros con las mulas…

Lo que me preocupa, está un poco en la línea de lo que dice XAQUÍN, la posibilidad de que la AI tenga sesgos ideológicos, no porque los genere ella misma, sino porque se la «eduque» con la finalidad de que los adquiera.

Los seres humanos tenemos tendencias a pensar que la «verdad» mecánica es una verdad absoluta, creemos que una fotografía o una filmación es la «verdad», cuando solo es una «verdad parcial» que representa solo el punto de vista del autor.

¿Cómo detectar este tipo de sesgos, en una AI si además se le «educa» a disimularlos?.

Reconocer que por más que sean sombras proyectadas en el fondo de una caverna, no dejan de ser solo eso: sombras.

Ergo: pensamiento crítico.

¿ Y que crees que hará Musk con Grok?

Meterle un sesgo ultraderechista que el da por bien empleado en la creencia sincera de que lo hace para neutralizar el sesgo «woke» que el cree que viene de fabrica en todos los datos con los que se entrena la IA,

¿Pero adopción tecnologica de qué?. ¿Qué es lo que hay a día de hoy tan revolucionario, que puede uno ya decir que le ha cambiado la vida?.

Tan criticable son las actitudes defensivas de mucha gente hacia la IA, como los gurus de la misma que hablan de ella como si de una religión se tratara.

Personalmente pienso que no estaría de más esperar a ver, porque muchísimos de los productos de IA que se ofrecen actualmente no son, ni de lejos, «game changers». Incluso cosas cómo las herramientas de Google o Apple Intelligence, por muy interesantes que parecen, aportan cambios grandes al usuario normal, y muchas están o en Beta, o en un proceso al que aún le quedan años para una adopción masiva.

Personalmente creo que a la IA verdaderamente revolucionaria le queda aún mucho tiempo hasta que realmente funcione como a día de hoy se imagina. No veo la necesidad ni de asustar, ni de sugerir a la gente que o te metes a ello, o te vas a quedar obsoleto.

Sí son ‘game changers’, Carlos. Solamente que aún no se han implementado a gran escala porque estamos en los inicios y además las novedades y avances se suceden casi cada día, pero preveo cambios brutales en muchas profesiones.

No es que tengas a tu disposición casi todo el conocimiento (útil) humano (como podría ofrecer Internet), es que tienes un asistente personal con el que interactuar y pedirle soluciones específicas a lo que necesitas, haciendo él uso de todo ese conocimiento. Él va a generar las soluciones en lugar de tener que hacerlo tú con un conocimiento muy limitado (porque uno puede tener acceso a toda la información del mundo pero somos incapaces por tiempo y capacidad de asimilarlo todo).

Estoy pensando en todos los asistentes, asesores, consultores, profesores, ilustradores, traductores, escritores, programadores, gestores, administradores… y muchas profesiones más que me dejo en el tintero. Tal y como lo veo dentro de poco muchos de sus servicios podrá ofrecerlos una IA… ¡gratis!

De hecho en cosas que «ya se saben» y se estudian en libros deben ser buenos por definición ( aunque no guste lo de loro), significa que pueden enseñar Historia, Geografia, Lengua, Matemáticas, Física, Programación, etc a un nivel de «doctorado»

Han pasado en 2 años del nivel bachiller a un nivel universitario ( no todos los LLM es verdad) pero dentro de 2 años ¿que tendremos? sinceramente: No lo sé

Solo creo que no serán grandes creativos, pero imitar la creatividad, o la consciencia,… al tiempo,…

Creo que OpenAI acierta con su visión de los 5 pasos o niveles,

Nivel 1: “Chatbots”, es decir, inteligencia artificial con lenguaje conversacional

Nivel 2: “Razonadoras”, aquellas con capacidad de resolución de problemas a nivel humano

Nivel 3: “Agentes”, o sistemas que pueden tomar acciones en nombre de un usuario

Nivel 4: “Innovadores”, inteligencia artificial que puede ayudar en la innovación

Nivel 5: “Organizaciones”, inteligencia artificiales que puede hacer el trabajo de una organización

Ahora estamos en el nivel 1.

ya hay artículos científicos donde la propia AI crea soluciones científicas novedosas en ciencia de la propia AI (es decir, se han leído los papers, han visto oportunidades de investigación, las desarrollan e investigan, y te escriben el artículo).

Es decir, estamos casi en Nivel 4. Ahora bien, hacer las cosas con la «fiabilidad» humana…es otra cosa.

Prueba a pedirle que te implemente una convolutional network para clasificación de series temporales en variable compleja (algo relativamente reciente) en pytorch y que te de referencias,y verás la revolución…

Es cierto que para la persona de la calle puede que no sea game changer, pero en las cosas técnicas va a haber un antes y un después

1. El que tenga oídos, que oiga, Mateo 13:9-15

2. It’s technology, stupid!

Mientras tanto, veamos como la IA es capaz de dar vida a algunos conocidos personajes de nuestra historia :-)

https://x.com/froggyups/status/1822537407427748057

Un buen actor unido a un buen maquillador, podría hacer algunas de esas replicas de seres extraordinarios.

Pero lo importante, es si además se consigue que el avatar de Van Gogh , por ejemplo, pinte cuadros al estilo de Van Gogh y que nos parezcan geniales.

.

Imaginad ser un estudio o profesional de los efectos especiales y ver que esto es lo que viene (lo que ya está aquí mejor dicho):

Vídeo corto demostración Pika 1.5

Te estalla la cabeza (nunca mejor dicho).

«estoy absolutamente convencido (…) de más calado y con efectos mucho mayores (…) que la llegada de internet y la web».

Uhmmm, pues no, porque sin internet y la web, ya se me dirá a mí que demonio de IA iba a existir cuando precisamente se sostiene de la web y de internet.

¿Efectos mayores? Bueno, eso ya es otro cantar, no digo que no, pero serán a su vez deudores de las ocurrencias del señor Tim Berners-Lee.

¿Que seria de la AI sin la luz eléctrica? Y sin la el descubrimiento del cobre, ¿Como podríamos utilizar la luz eléctrica,?,… Todo se lo debemos a la tecnología del Cromagnon.

¿Y los romanos? ¿Qué han hecho los romanos por nosotros?

lol

Eso,… los romanos, y los chinos, ¿que han hecho los chinos por nosotros.? .-

Los Smartphones y tablets.- Si, de acuerdo, los Smartphones y tablets

.

Ordenadores y componentes.- Si, también ordenadores y componentes, pero principalmente la china de Taiwan´

Electrodomésticos, televisores, refrigeradores. lavadoras, pequeños electrodomésticos,… También es cierto, China es un líder en la fabricación de productos para el hogar.

Equipos de telecomunicaciones, routers, switches y antenas,… Bien, los chinos han hecho bastantes cosas por nosotros, pero ¿quien invento Internet…?. Tim Berners-Lee, americano.

Este comentario y el de abajo, es coger mi comentario como se coge el rábano por las hojas. O sea, NO haber entendido nada de nada.

Vaya, pensé que mi comentario de arriba iba a quedar entre el de Gorki y el E. Dans, pero se ha ido por debajo de los dos. Entonces me corrijo y digo: los dos comentarios de arriba.

Lo hemos entendido todos perfectamente, créeme.

No sé yo…

Interesante artículo profesor Dans.

Personalmente no sé si las IA, como revolución tecnológica, están por encima del Internet y de otros tipos de tecnologías que también han revolucionado la historia del ser humano; como la escritura, el fuego, electricidad….

Hay que pensar todo lo que ha traído Internet a nuestras vidas, que muchas veces damos por sentado, pero que si un señor que murió hace 40 años levantara la cabeza quedaría cuanto menos, atónito.

Empleo a diario GPT o Claude Sonnet y son una extensión como herramienta de productividad, francamente espectacular. Cuando determinados gremios, como por ejemplo el de la medicina, empiecen a apoyarse en este tipo de herramientas, creo que se mejorará mucho el «servicio» prestado a los pacientes.

Me ha sorprendido también lo que comenta de que estamos «al principio de esta evolución». O sea, ¿que estos algoritmos LLM todavía tienen mucho margen de mejora?

Pues fíjate que, así para variar, estoy de acuerdo con Enrique. Va a ser un cambio absoluto de paradigma. Voy a intentar hacer un repaso a las cosas que ya se pueden hacer y las que no (no solo LLMs, sino toda la AI), pero que en breve sí lo serán (basándome en mi experiencia con perplexity.ai, que te da las referencias que ha usado para responder):

De momento puede que se note más en las ciencias y las ingenierías: desde signal processing (desde lidar hasta MRI), evolución de sistemas dinámicos ultra-complejos (magnetohidrodinámica para plasmas en fusión nuclear, hasta predicción del clima)…hasta procesar el output gigantesco del LHC.

Pero sin duda puede llegar a afectar a todo el mundo: créame un blog desde cero, llévame las cuentas del año, explícame las leyes de Maxwell (o dime cómo resolver el campo electrostático en un cilindro semihueco), redáctame un contrato de arrendamiento para un amarre (ejemplo real de una amiga en Mallorca)….en fin.

Si sabes preguntar, e ir refinando su output, acaba dándote algo cercano a lo veraz (este arte hay que desarrollarlo, por el momento).

También estuve probando las capacidades sobre teoría musical (music chatgpt, y perplexity) con temas bastante avanzados de jazz. Ahí falla más que una escopeta de feria, pero si le vas diciendo «no, la V de tal acorde es G7, etc», va afinando. La parte mala está clara. La buena es que le puedes preguntar qué es un dominante secundario, que te diga un tema en el que se use, que te de una lista de acordes substitutos, que te rearmonice un tema….Claro, luego te queda la faena de pulir y darle sentido, pero está claro que está en el comienzo.

Para mí, sin duda, la revolución ocurrirá con el siguiente salto de escala (de cantidad de «neuronas»), que ahora es imposible porque el hardware de silicio no creo que sea adecuado (lo hemos hablado muchas veces en este blog, gasta demasiado). Ahí vamos a flipar y probablemente veamos algún comportamiento emergente que nos deje con el culo totalmente torcido.

PD: Hace poco en mi curro hemos entrenado una red (simplísima) que es básicamente unas cuantas capas convolucionales y luego un par de capas densas para clasificación. Consigue hacer una clasificación, que sin AI necesita 30 veces más datos, que te pones a mirarla matemáticamente por todos los lados y te quedas flipando como si te hubieras tomado un tripi. Ahí lo dejo.