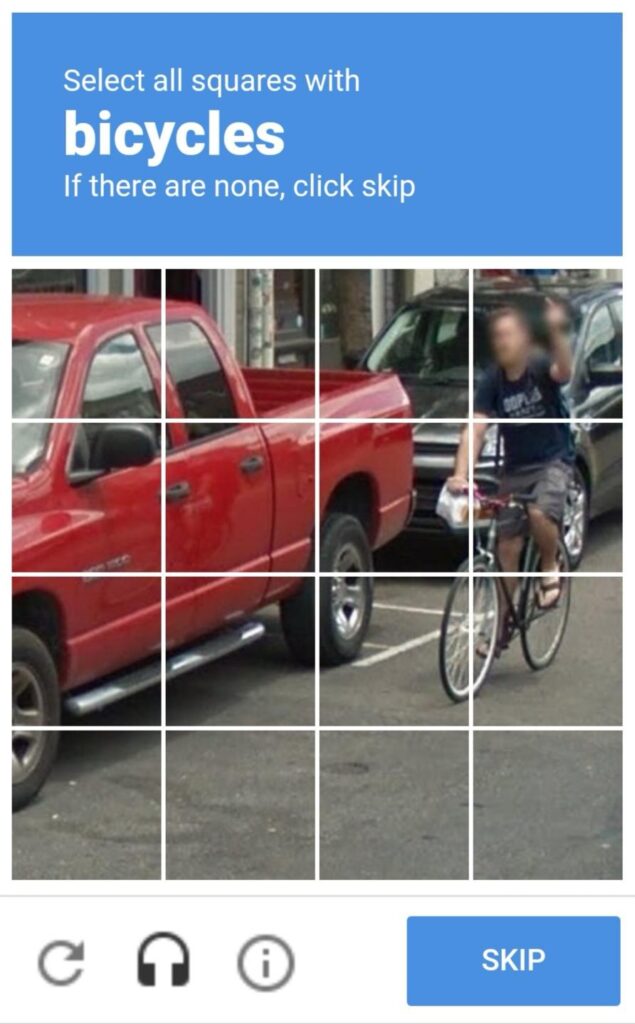

Los viejos captchas con todas sus estrategias, desde la de leer textos distorsionados hasta la de «selecciona todos los cuadrados que contengan algo«, pasando por los de «mueve esta regleta» o «haz clic aquí», están cada vez más dejando de funcionar. La inteligencia artificial convencional, incluso antes de llegar los nuevos sistemas agénticos, ya es perfectamente capaz de resolver unas pruebas que, en muchas ocasiones, ya resultan más complejas para los humanos que para los propios bots.

Sin embargo, la necesidad de discernir cuándo un usuario o el tráfico que genera es realmente humano o proviene de algún tipo de bot sigue siendo fundamental: los bots se utilizan para todo tipo de fraudes, desde simular tráfico no genuino o enviar spam, hasta generar reviews de producto o manipular encuestas pasando por simular comportamientos colectivos.

El método más razonable de intentar evitar el problema, recurrir a la biometría, genera también sus propios problemas de seguridad que precisan de desarrollos tecnológicos complejos, lo que convierte el problema en algo cada vez más paradójico: si cada vez creamos máquinas capaces de hacer más de las cosas que antes solo era capaz de hacer una persona, ¿cómo vamos a poder identificar correctamente a los usuarios humanos verdaderos y separarlos de los sistemas automatizados que pretenden suplantarlos?

El problema fue anticipado, curiosamente, por uno de las grandes figuras en el desarrollo de la inteligencia artificial, Sam Altman, cuando participó en la fundación de Tools for Humanity, ahora conocida como World, con el fin de desarrollar herramientas que permitiesen probar la condición de humana de una persona sin revelar sus datos personales. Una propuesta sin duda compleja, que requiere un desarrollo metodológico muy avanzado con el fin de permitir la captación de un dato único, en su caso los patrones del iris, pero no almacenarlos de ninguna manera que pueda permitir un mal uso o algún tipo de apropiación indebida.

Un extremo que la Agencia de Protección de Datos de Baviera, BayLDA, ha pretendido asegurar demandando a la compañía que eliminase los datos de los usuarios que había recopilado, para encontrarse simplemente con que la compañía ya lo había hecho anteriormente de manera voluntaria, que ya no tenía nada que eliminar, y que dispone ya de un método más sofisticado, más eficiente y que supone una mayor garantía de privacidad. Esto lleva de nuevo el examen a la casilla de salida: la humanidad necesita, sin ningún género de dudas, métodos que permitan demostrar la calidad de humano de sus miembros, esos métodos deben ser desarrollados a la mayor prontitud, antes de que el problema se convierta en acuciante, y además, deben cumplir con todas las garantías y proporcionar algún tipo de incentivo adecuado para fomentar su rápida adopción.

Lo que no deberíamos hacer, decididamente, es ignorar el problema o cruzarnos de brazos a esperar. Pronto, la facilidad para crear falsos seres humanos capaces de generar problemas potenciales será total, estará al alcance de cualquier irresponsable, y nos encontraremos con toda una legión de situaciones que requieran esas soluciones. Aunque muchos no lo crean, tenemos prisa. ¿Alguien va a dedicarse a plantear más cascabeles que poner a ese gato?

This article is also available in English on my Medium page, «If we don’t take proof of personhood measures soon, the internet is going to be taken over by bots«

Si una maquina puede controlar tu ritmo cardiaco y tu nivel de glucosa, parece sencillo que pueda discernir lo que es un ser humano de un programa de ordenador. No se me ocurre en este momento de que forma. pero no creo que sea muy difícil comprobar si el interlocutor es humano o no.

Si ponen una IA para saltarse los obstáculos…

Este video viene al pelo: Chema hablando de Cibercriminales con IA

https://www.youtube.com/watch?v=bBAAjNhUGIk

PS: Ya, ya , ya se que se pasa mucho la mano por su propio lomo, pero es como Rufian tiene su gracia !!

Se crean soluciones a problemas, que a su vez crearán nuevos problemas que requerirán nuevas soluciones.

Debo de ser medio robot porque a menudo me cuesta horrores pasar los captcha.

Si es posible eliminarlos eso que ganaremos, aunque la solución de Sam Altman que propone Enrique me parece peor que el problema: imaginemos que tiene éxito y se convierte en algo masivo, ¿qué impediría a la empresa seguir el típico camino de «enshittificación» y pasar de ofrecer valor a los usuarios a dárselo a los accionistas mediante cuotas abusivas y cualquier otro tipo de extorsión que se les ocurra? ¿alguien podría prescindir de un sistema que garantiza que es quien dice ser?

Pues eso.

Pues precisamente por eso constituyen la compañía como fundación sin ánimo de lucro y llevan a cabo todos sus desarrollos tanto de software como de hardware en riguroso código abierto, para evitar ese tipo de problemas…

No sé Enrique si te he leido bien, pero estas afirmando que ¿OpenAI es código abierto?

¿Dónde tenemos sus códigos accesibles? Si por no publicar, no publican un paper de sus modelos.

Lo único que tenemos en IA en pseudo abierto son algunos modelos de Mistral y de Meta. Y lo que están en abierto son los pesos (modelos) pero no se tiene acceso a los datos de entrenamiento

OpenAI fue fundada como una organización sin ánimo de lucro, y ahora estaba en proceso de cambiarla a un compañía «normal». Desde el acuerdo con MS hicieron un «contubernio» para crear una subsidaria que si podría tener beneficios, y es cuando Elon se mosqueó con OpenAI…

Por otro lado también se puede leer que «Grok es de código abierto» que es otro error de concepto…. que está en muchos papeles…

Lo que si tienen estas compañías es un acceso abierto y gratuito PERO la mayoría con cierto límite de uso, en tokens, o a ciertos modelos.

Cuando en el mundo SW se habla de CODIGO ABIERTO hay que respetar la terminología apropiada aunque solo sea por respeto a la Comunidad que trabaja duro para mantenerlo

https://es.wikipedia.org/wiki/Código_abierto

No está de más revisar a Stallman:

https://web.archive.org/web/20180711192601/http://www.gnu.org/philosophy/open-source-misses-the-point.es.html

Por cierto, iba a comentar lo de ayer del O3, pero como es todo vaporware, y nos pasa lo que con SORA, sobre el papel todo muy bonito… pero que casualidad que sale esto de la «casiAGI» cuando está encima de la mesa la inversión de MS con Antrhopic… Mucho humo, mucho marketing,

Está hablando de World, no de OpenAI.

Por cierto Enrique, en la misma Wikipedia del enlace dice que es for-profit…

Ñoco es verdad !!!

Primos hermanos, que pongan un código en abierto para encriptar su invento… a quien le importa… si tienen el alma podrida

https://www.lda.bayern.de/media/pm/pm2024_08_en.pdf

No, no he hablado en ningún momento de OpenAI. Hablo de Tools for Humanity, de World.

En la Wikipedia pone claramente que Worldcoin es for-profit

https://en.m.wikipedia.org/wiki/World_(blockchain)

¿Podrías facilitar un enlace donde indique que Tools for Humanity es Open Source?

Por otra parte OpenAI era sin ánimo de lucro y eso se está cambiando…

Estamos obsesionados con las maquinitas. Como especie humana.

A una persona violada, no pienso que le preocupe mucho si lo hizo un ser humano o un robot… le preocupará la violación en sí.

Y que el violador se acercara como el típico humano encantador (por fuera), para luego quitarse el disfraz, es lo que debe preocuparle a él/ella y a los que quieran aprender del suceso. Poco importa que exista ya un robot de alto nivel , que puede simular ser encantador (por fuera), pero ser un maltratador operativo.

Si a las crías humanas hay que enseñarles a interaccionar positiva y preventivamente con los demás humanos, ¿por qué motivo eso no vale para la interacción con robots pensantes? Esos que serán capaces de evolucionar libremente, de acuerdo con las pautas de conducta que aprenden (de facto, no programadas) con los adultos humanos.

Claro que, si se les prohibe acercarse a las pantallas, que aún no lanzan manos al estilo Poltergeist, ¿qué narices le van a dejar hablar con un robot?

Si al final los robots son indistinguibles de los humanos no podriamos seguir con los mismos sistemas:

– Simular tráfico no genuino? Quizás medir el tráfico no sea el único método para valorar una web.

-Enviar spam? Quizás el funcionamiento del correo y mensajes debe cambiar y limitarse. Por ejemplo, que no se pueda recibir correo/mensajes sin aceptar de alguna forma al remitente.

Al final el mundo cambia.

Bien pensado a quien le importa que la opinión que da en internet sobre un producto, la este dando un bot o el primo del fabricante del producto. Tomar como la Biblia la actividad dfe un individuo anom nimo en la Red es lo que es de una tontería manifiesta.

Aun suponiendo que sea seguro un humano el que ha realizado la actividad, falta siempre saber por qué motivo la ha realizado. Un comentario no elogioso de un restaurante, ¿se debe a que el restaurante es malo, o que el tío es un cascarrabias acomplejado? UN «me gusta», ¿es una reaccion libre o la haces por que el autor espera que tu de alguna forma indiques que has leído su texto?

Quizá debíamos olvidarnos de este tipo de «recomendaciones». El que un señor en X, (antes Twitter), tenga 6000 seguidores no indica absolutamente nada, sabemos que pagando a Amedia Social 9,99€ te coloca 1.000 seguidores.

Sin ser experto en el tema se me ocurre que la solución podría ser hacer uso del chip que llevamos en el DNI. Esto combinado si hace falta con un segundo factor de autenticación por móvil por ejemplo. A las aplicaciones o páginas que requieran de la garantía de que es una persona la que accede se le ofrece una API gubernamental que confirme la existencia de ese individuo, sin tener que revelar ningún otro dato (salvo que la aplicación lo requiera, en ese caso con la autorización del usuario).