Me ha llamado mucho la atención algo sobre lo que llevo tiempo escuchando avances, la aplicación de machine learning al modelado o previsión del tiempo, y encontrarme con un modelo publicado por DeepMind, la compañía fundada por Demis Hassabis, Shane Legg y Mustafa Suleyman en 2010 y adquirida por Alphabet por $650 millones en 2014. Es algo sobre lo que uno de los cofundadores de BigML, Tom Dietterich, lleva también tiempo trabajando, y sobre lo que he tenido también oportunidad de conversar con él en alguna ocasión.

El modelo, denominado GraphCast, es capaz de superar significativamente a los sistemas deterministas operativos más precisos creados por agencias gubernamentales europeas o estadounidenses, de mejorar en el 90% de los 1,380 objetivos de verificación, y de pronosticar de manera muy precisa eventos severos como ciclones tropicales, ríos atmosféricos, olas de calor y otras temperaturas extremas.

En un planeta cada vez más desestabilizado por culpa de la emergencia climática provocada por la acción del hombre, disponer de sistemas capaces de pronosticar con fiabilidad la evolución de los fenómenos meteorológicos es cada vez más importante. Para ello, la aproximación de DeepMind ha sido la de plantear un modelo de machine learning: partir del re-análisis de más de cuarenta años de datos históricos anotados con las evoluciones climatológicas que generaron en su momento, y utilizando la capacidad de computación necesaria para manejar un modelo con varios centenares de variables, la compañía ha obtenido un modelo capaz de predecir cientos de variables meteorológicas, durante un período de 10 días y con una resolución global de 0.25°C, en menos de un minuto.

El pasado septiembre, los modelos de inteligencia artificial desarrollados por Google, Nvidia y Huawei determinaron el pronóstico de la trayectoria del huracán Lee con una semana de anticipación: Lee se intensificó rápidamente hasta convertirse en un huracán de categoría 5 en el Océano Atlántico al este del Caribe, y luego se debilitó antes de tocar tierra en Nueva Escocia con una fuerza equivalente a una tormenta tropical. A pesar de ser un fenómeno con una evolución relativamente inusual y repetido en pocas ocasiones anteriores históricamente hablando, derivado de las temperaturas anormalmente elevadas de la superficie del mar que «realimentan» este tipo de huracanes, los modelos de machine learning son aparentemente capaces de predecirlos con gran exactitud.

Mientras los modelos meteorológicos tradicionales hacen pronósticos basados en complejos cálculos matemáticos y ecuaciones, y requieren enormes cantidades de potencia informática, los modelos como GraphCast, basados en AI llevan a cabo un enfoque diferente, mediante el reconocimiento de patrones en grandes cantidades de datos meteorológicos históricos que les permiten, posteriormente, generar pronósticos ingiriendo las condiciones actuales y aplicando lo que aprendieron de aquellos patrones históricos. El proceso requiere mucho menos procesamiento computacional y puede completarse en minutos o incluso segundos en ordenadores mucho más pequeños. Además, es capaz de mejorar la precisión del pronóstico al capturar patrones y escalas en los datos que no estaban representados en las ecuaciones explícitas manejadas anteriormente por los meteorólogos.

Una mejora así es susceptible no solo de mejorar los modelos de predicción meteorológica de los que disponemos, sino también de ser aplicado al estudio de la propia emergencia climática, añadiéndose a la ciencia de la atribución climática que ha generado ya datos fehacientes para comprobar que, en efecto, la frecuencia y la severidad de los fenómenos climatológicos se ha incrementado en gran medida en épocas recientes, y que es debida, además a un efecto puramente antropogénico.

Todo indica que, a medida que este tipo de modelos se vayan incorporando cada vez más a las predicciones de productos de cara al público – como Google ya ha hecho con un modelo anterior, MetNet, una red neuronal dedicada al cálculo de precipitación, temperatura de la superficie, velocidad y dirección del viento y punto de rocío – veremos pronósticos cada vez más certeros, y podremos, dentro de un orden, intentar prepararnos mejor para sus efectos. En un planeta cada vez más inestable, esto va a ser cada vez más importante.

This article is also available in English on my Medium page, «How machine learning will help us prepare for extreme weather events«

Me parece in artículo superinteresante. Se abre así una ventana nueva de posibilidades casi infinitas. Un sistema fiable al fin con los parámetros adecuados y con el resultado correcto.

Lo siguiente será alimentarle datos más antiguos con la mitad de variables, pero extrapolando el resuktado historico para obtener el clima, por ejemplo, de los romanos o fenicios y así calcular mejor el impacto (o no) de los seres humanos en determinados hábitats.

Y en la otra dirección, puedes también vaticinar el futuro mejor si somos capaces de predecir la variables correctas. Y si nos equivocamos, ajustamos los parámetros y volvemos a intentarlo.

Llegará el momento en el que sí podamos predecir el futuro. Por ejemplo, en el nivel del mar ninguna predicción ha dado en el clavo, todas las costas están igual ahora que con Alejandro Magno. Y por más hielo que se funda, si sube la temperatura también aumenta la evaporación, y el exceso de nubes podría reflejar el sol y bajar las temperaturas de vuelta o hacer de caldera de calor (como venus).

Me encantaría saber si España puede desertificarse o no, o como evitarlo en función de X parámetros. Menuda bola de cristal, una de verdad al fin

…va a ser que no…

Pero es un argumento trufado. La ciudad se hunde (como Yakarta), no es el mar que sube. Y eso según el artículo

Pues está bien que surjan alternativas al sistema actual de predicción climatica dado que…» algunas de las frecuencias a las que operan las nuevas redes 5G están próximas a una ya ocupada (la de 23,8 gigahercios) para tomar valiosas mediciones de los satélites usados en las predicción del tiempo».

Lo que se prevé con esta ocupación de las frecuencias que utilizaban hasta ahora los satelites climáticos es un empeoramiento en la predicción del clima.

Otro modelo interesante es el proyecto Tierra de Nvidia,

https://www.nvidia.com/en-us/high-performance-computing/earth-2/

https://es.wikipedia.org/wiki/Teor%C3%ADa_del_caos

Cuando un modelo es caótico, como el del tiempo atmosférico, necesitas tener una infinidad de puntos de medida y cualquier previsión se deteriora en cuestión de pocos días. Como demuestran estas iniciativas.

El uso de Deep Learning puede ser una buena ayuda para el manejo de esa avalancha de muestras de datos para modelizar el tiempo atmosférico, nunca una infinitud de ellos, y la dificultad de conocer las variables necesarias en cuatro coordenadas, de ahí que no se pueda ampliar mucho más en el tiempo las predicciones, lo que no va hacer nunca ningún Deep Learning es convertir un sistema caótico en un sistema determinista, pero eso si es una buena herramienta de apoyo, y si logra 10 días de predicción, pues buenos son.

Totalmente de acuerdo. El clima es un sistema caótico, de ahí que sea tan difícil hacer buenas predicciones, en especial a medio o largo plazo.

Lo que veo, y celebro, que aporta el ML es la modelación automática del clima que, además, parece que requiere menores recursos computacionales.

En su momento había oído hablar de modelos matemáticos tan complejos que la predicción climática para una hora determinada tardaba en computarse varias horas más de la hora de predicción, por lo que sólo servia para comprobar si el modelo era suficientemente exacto o no.

Toda ayuda para la predicción del tiempo es bienvenida. Hay muchos aspectos de la sociedad y las actividades económicas en particular, que dependen de una buena predicción climática.

Pues a ver si con Machine Learning mejoran las predicciones, pues actualmente, con los modelos matemáticos supercomplejos etc., aciertan lo mismo que Mariano Medina con las isobaras pintadas a mano y los barcos en medio del Atlántico.

Indudablemente, ahí donde haya que tener en cuenta, no solo millones de datos., (cuantos datos proporciona una sola foto de un satélite), sino además, cómo estos datos evolucionan con el paso del tiempo, será posible que una máquina, con el refuerzo de la AI, de resultados mucho mas correctos que Mario Picazo, por mucho conocimiento que tenga este señor de metereología,

A lo que tendrán que dedicarse los Mario Picazo del mundo, es a diseñar los algoritmos inteligentes que tienen que hacer actuar la máquina con AI. Creo que BENJI, nos indica el Libro Blanco que hay que seguir para afinar sus resultados.

Yo creo que utilizar estos aparatos a las predicciones de sistemas caóticos, no solo del tiempo, sino mas interesante aun , dedicado a los cambios sociales, será algo común en el futuro por las implicaciones económicas que tiene.

Te imaginas una máquina capaz de predecir en función del tiempo que hara el año que viene, el tamaño de las cosechas de todos los productos alimenticios que se produzca, Granos, aceites, ganado,… ¿No permitirán a los ricos hacer acopios, esperando que suba el precio de lo adquirido, mientras que se apresuran a vender con descuento, aquello en lo que una superproducción bajará los precios.

Te imaginas poseer una máquina que prevé cuales van a ser las enfermedades contagiosas futuras, ¿No permitirán hacer las vacunas antes y no después de que aparezcan.

Saber cual va a ser la moda dentro de un año, ¡Las posibilidades de hacer negocio que tiene!,

Y una máquina de saber la opinión de la gente con anticipación, ¿No permitirá al demagogo de turno ponerse al frente de estos movimientos! .

Como siempre cualquier invento, puede utilizarse para el bien o para el mal

Yo siempre he tenido el sueño/ficción húmedo que me permitía conocer el periódico del día siguiente, para poder comprar en la Lotería los números premiados. Quizá este tipo de máquinas permita a sus poseedores, (los poderosos), hacer muchas de las cosas que yo pudiera haber hecho, si hubiera encontrado el gusano que me llevara al futuro, aunque fuera con solo 24 horas de adelanto.

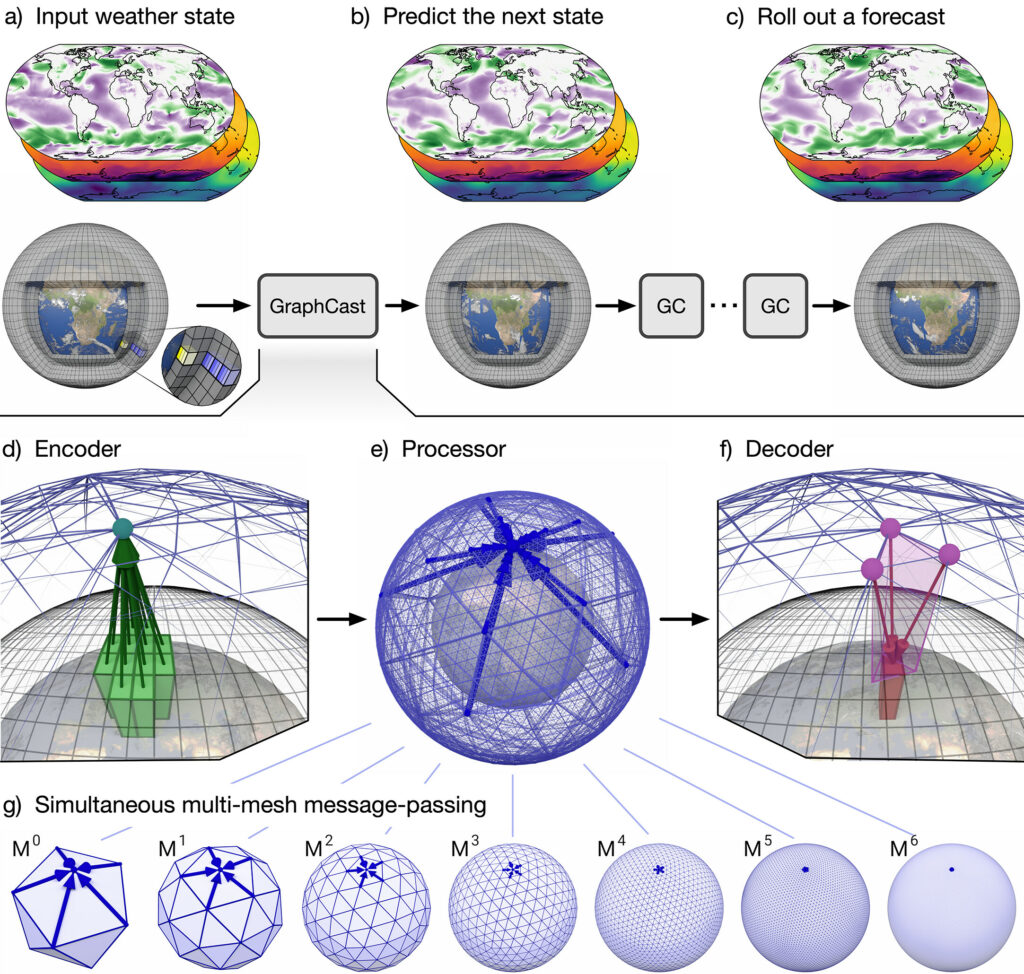

Supplementary material, sección 3.2

«GraphCast is implemented using GNNs in an “encode-process-decode”»

GNN (graph neural network) se basan en mesh-grids (como finite-element para simular cosas con ecuaciones diferenciales) pero aprenden la interacción de los nodos (qué cosas emergentes interaccionan con otras cosas emergentes y cuales no). Son mejores que CNN porque un nodo no solo interacciona con sus vecinos. Son mejores que Transformers porque éstos, aunque tengan all-to-all interactions, escalan cuadráticamente en memoria.

En cuanto al tema de que es caótica la dinámica atmosférica: los exponentes de Lyapunov (que «te dicen cuántos días vas a poder predecir») dependen de a qué nivel de detalle estás mirando (hay una interacción entre escalas) y precisamente la virtud de las GNN es que «descubren» estructuras de interacción a varias escalas sin necesidad de simular todas las escalas en detalle (imposible computacionalmente, de ahí que HRES lo haga peor que esta red).

Al final es como buscar la representación irreducible de dicha dinámica, y más allá de eso todo es echar más recursos computacionales.

En cuanto a la dinámica «humana»: probablemente la dinámica de opinión de la gente es mucho más sencilla de predecir que el tiempo atmosférico…

Por otro lado: deberíamos crear un movimiento que diga «todas las GPUs dedicándose a problemas importantes!!». Es decir, nada de LLM y mierdas de gatitos. Las GPUs son un recurso limitado y estamos en un momento de emergencia absoluta a muchos niveles. Necesitamos todo el poder de computación para predecir clima, desastres, evolución de cosechas, de plagas, de movimientos masivos humanos, de predicción de eventos desastrosos económicos y geopolíticos…

+1000 al ultimo parrafo