La alerta comenzó en Twitter: un emprendedor y creador de Ruby on Rails con más de 358,000 seguidores, David Heinemeier Hansson, compartía un hilo en el que detallaba como su mujer, que había solicitado la misma Apple Card que él, únicamente obtenía un límite de crédito unas veinte veces inferior que el suyo, a pesar de que declaraban impuestos conjuntamente y de que, además, ella tenía mejor historial de crédito que él.

En su explícita reclamación, que rápidamente se viralizó con el testimonio de otras personas que habían experimentado casos similares, afirmaba haber apelado a la compañía y no haber obtenido respuesta, y logró poner en marcha todas las alarmas, desencadenar una investigación del New York State Department of Financial Services por discriminación de género, y llevar a que la entidad emisora de la tarjeta, Goldman Sachs, anunciase que reevaluaría el cálculo de sus límites de crédito.

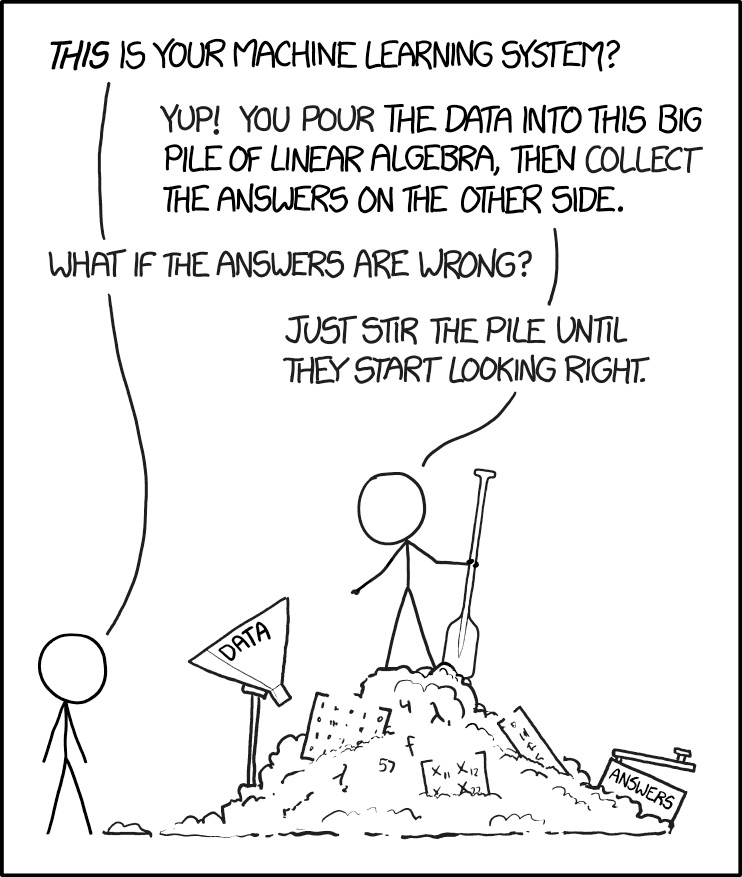

La queja de David, en la que hacía exclusivamente responsable del problema a Apple, resulta curiosa viniendo de un desarrollador con experiencia: un sistema de machine learning es tan bueno como los datos con los que lo alimentamos, y no hace tanto tiempo que la sociedad, de manera generalizada en los países desarrollados, sostenía importantes sesgos en función del género de las personas, particularmente en entornos financieros. Obviamente, eso era algo que había que corregir, y en la mayoría de esos países desarrollados se está en vías de hacerlo – podríamos discutir si se hace o no con la velocidad adecuada – pero eso, me temo, no impide que muchos de los datos que utilizamos aún provengan de épocas en las que ese sesgo era un componente significativo de las sociedades occidentales (y en otras es aún peor).

El sesgo en los algoritmos de machine learning no indica necesariamente ningún tipo de intencionalidad ni de discriminación en la empresa que comercializa un producto o servicio. La discriminación, obviamente, sí se produce de facto, y por tanto, debe ser corregida, algo que precisamente puede hacerse a partir de las denuncias de los usuarios, que son quienes, en último término, pueden experimentarla. Pensar que los algoritmos reflejan algún tipo de intencionalidad es como pensar que son infalibles, cuando en realidad, son simples procesos matemáticos que procesan datos. Si esos datos están sesgados en su origen, esos sesgos reaparecen en sus decisiones, y será así mientras ese sesgo original en los datos no se corrija o sea matemáticamente descontado mediante métodos que corrijan el sesgo muestral o sample bias. Es un tema que llevo años comentando en mis clases con ejemplos de diversos tipos, y que no resulta tan difícil de entender.

El machine learning se está convirtiendo en una de las tecnologías más interesantes y prometedoras para obtener una automatización de procesos infinitamente más sofisticada, potente y flexible que la que disfrutábamos cuando simplemente programábamos dando nombre a variables y planteando condicionales y bucles. Aplicar machine learning supone acceder a reglas muchísimo más inteligentes, potentes y flexibles, que se van corrigiendo a medida que los datos de la muestra van evolucionando, que reconocen variaciones en función de muchísimos factores, y que tienen capacidad para ir haciéndose mejores con el tiempo. Se habla, incluso, de utilizar la historia como una enorme base de datos para alimentar algoritmos, algo que requerirá la participación de perfiles de muy diversos tipos.

Suponer algún tipo de «perversidad» en los algoritmos o en las compañías que los utilizan y dedicarse a acusar a Apple de machismo es, a estas alturas de película, tan ingenuo como suponer que los algoritmos son correctos porque provienen de algún tipo de bola de cristal o poder místico. No, no es así: el machine learning es y será durante mucho tiempo un generador de algoritmos sesgados debido a los datos con los que alimentamos los algoritmos, sesgos que habrá que vigilar, controlar y eventualmente corregir. Las protestas tienen valor, y lo único que hay que reclamar es que las compañías investiguen los efectos de sus algoritmos cuando se intuyan comportamientos discriminatorios, y los corrijan, aunque sea manualmente, cuando sea necesario, y realimenten sus algoritmos con esas correcciones. No, no toda discriminación es resultado de algún tipo de mala intención o sesgo explícito, a veces son sesgos implícitos no necesariamente fáciles de visualizar que provienen, simplemente, de la matemática.

El machine learning va a estar en todas partes, el mercado del Machine Learning as a Service (MLaaS) va a crecer muchísimo en los próximos años, y además, es muy posible que separe a las compañías que triunfan gracias a su sofisticada automatización de aquellas que fracasan por seguir haciendo las cosas como las hacían tradicionalmente. Cuando utilices machine learning, asume que es posible que surjan sesgos que no has tenido en cuenta porque provenían de los datos originales, y prepárate para saber darles respuesta adecuada y rápidamente si aparecen. Si automatizas, sé sensible a los posibles problemas y sesgos que surgen de esa automatización. Vamos a convivir con algoritmos de manera habitual, y ello conllevará que tanto las empresas que los utilizan como los clientes que los experimentan sepan que ni son perfectos, ni tienen necesariamente la razón… aprendamos a reconocer esto sin pensar en conspiraciones y sin hacer dramas al respecto.

This post is also available in English on my Medium page, «Yes, that’s right, some algorithms are biased; we have to work on improving the data we feed them«

El límite de las tarjetas de crédito no utiliza machine Learning. Utiliza el FICO score y el ‘Credit Utilization Ratio’.

Son ratings de solvencia que se elaboran sin el empleo de ningún tipo de Machine Learning.

Es una ‘Fake Informatión’ o bulo.

Es más sencillo entender esa diferencia, si por ejemplo, las propiedades están a nombre del marido, o tiene un mayor historial de uso de tarjetas de credito y devolución de créditos.

Ni todos los algoritmos implican Machine learning, ni son sinónimos.

Del hype de la IA, si ya, luego, otro día.

–

Disclaimer

Hay rumores de que Leticia Sabater está a punto de lanzar una agencia de Fact Checking.

Vaya bulo que lleva cuatro días persiguiendo el asunto y nadie ni de Apple ni de GS le da la explicación que tú propones.

Este es el sistema de Scoring de Goldman Sachs para la Apple Card. Está basado en FICO Score 9, la última revisión, que incluye información sobre deudas en el seguro médico y créditos de estudios.

FICO® Score 9 Product Sheet

«FICO’s internal policies and procedures are developed to meet the risk management principles and supervisory expectations of the Office of the Comptroller of the Currency (OCC 2011-12) and the Federal Reserve (SR 11–7) Model Management Guidelines for development and validation of the models.»

El modelo de cálculo de riesgo está validado por la Reserva Federal, el equivalente del Banco Central Europeo en EE.UU.

No hay ni rastro de de Machine Learning por ningún lado. Su uso tendría que ser validado de igual forma.

Los scorings crediticios en EE.UU. son bastante transparentes para los usuarios y están auditados y certificados por la autoridad monetaria de EE.UU.

«FICO’s Model Methodology fully complies with Federal standards for governance and control mechanisms, including documented and audited processes with oversight from FICO’s senior management.»

En este enlace, está explicada la descripción de los modelos de scoring utilizado («Algoritmos para el cálculo del riesgo financiero») y los criterios de exclusión validados más habituales.

TransUnion Scores Overview

–

FICO® Score 9 Release Notes

Bueno, pues que alguien le dé a ese señor esta explicación, si es tan fácil.

Exponiéndolo de forma más clara, en este White paper FICO explica porque deliberadamente no utilizan Machine Learning en los scoring crediticios para evitar sesgos implictos en las muestras.

«Furthermore, overreliance on “ML-only” models can actually obscure risks and shortchange consumers by picking up harmful biases and behaving counterintuitively.

Such models could underestimate default risk or deny consumers improvements to their credit scores as they lower their debt.

This lack of explainability makes “black box,” ML-only models difficult to operationalize at any scale and, in turn, unpalatable to lenders and consumers, particularly those who are inexplicably denied credit.»

Machine Learning and FICO Scores

Por añadido, FICO además incluye un «Certificate of explainability» en su suite de calificación crediticia, donde describe cada paso dado en la toma de una decisión de crédito (incluido en tambien en el xAI – xML Toolkit).

The certificate of explainability is a description that provides the necessary information for an instance-level scoring to be trusted. Depending on the intended audience, the certification can include information at a varying degree.

xAI Toolkit: Practical, Explainable Machine Learning

Así que, no sé Rick…

–

We Didn’t Explain the Black Box – We Replaced it with an Interpretable Model

Lo había visto este fin de semana, pero ha sido leyendo ahora el artículo de Xakata cuando me he preguntado: qué raro que Enrique no haya escrito nada subre esto cuando se trata de uno de los temas estrella. He aparecido por aquí y … voilà.

Creo que hay que profundizar un poco más. Estamos casi en 2020 y todo el mundo sabe ya que si alimentas un ML con datos sesgados, obtienes resultados sesgados. Por tanto, se ha lanzado un producto al mercado:

a) Sin haberlo probado lo suficiente para limitar los sesgos,

b) y/o ‘discriminando’ de forma consciente.

El caso también muestra cómo el servicio de atención, desde el que atiende el teléfono hasta el management, no dispone de mecanismos para resolver esas situaciones. Parece que se debe a que han externalizado las plataforma a Goodman Sachs y no tienen control alguno.

Estoy de acuerdo con la visión general del artículo. Salvo en la visión buenista del uso de ML.

Supongamos que soy una empresa A que sé de créditos, y tengo unas reglas claras para gestionar sus riesgos. Entonces puedo tener una regla efectiva que analizando a una persona: no tenga en cuenta su raza, género, domicilio, ingresos, etc. ¿O si debo tenerlos?

Es decir si el índice de devoluciones de una mujer de raza negra es del 90%, y el índice de un hombre de raza blanca es del 80%. ¿ Es racismo decir que las mujeres negras son más cumplidoras?

Si alimentas a tu ML con esos mismos datos, y la ML decide que las mujeres negras tienen que tener más límite de crédito ¿ es eso racismo?

El problema de la empresa A es que usa ML para algo que no debería, si tienes claro tu política de crédito no seas tan necio de ir a lo fácil. La explicación de la caja negra y que el algoritmo dice que…

Lo que debe de hace la empresa A es tener los suficentes arrestos para pasar de ML y aplicar un Sistema Experto basado en políticas claras.

La ML la puede usar para deducir esas políticas del «big data» pero una vez estudiado el caso de la respuesta del ML y su aprobación en el comité de riesgo. Lo que no es asumible es poner en funcionamiento el resultado de un algoritmo y luego decir el típico «yo no sabía que…»

Otro «lugar común» de las empresas chapuceras es pensar que la salida de una AI no se puede detectar, se llama «hackeo». Te coges unos cuantos casos de salida conocida, en tu propia red neuronal y la entrenas con esos casos, y ya tienes la ML copiada… y a lo fácil dos casos parecidos como los de la muestra que cita Enrique, y les haces el lío.

Exacto, los algoritmos de machine learning alimentados con big data optimizan para conseguir un resultado concreto (maximizar beneficios por ejemplo) sin importarles el posible resultado discriminatorio (aunque los datos no estén sesgados). Incluso si pretendes eliminar una variable para que no discrimine, lo tienes complicado porque habrá otro montón de variables que sí están teniendo en cuenta y están de forma indirecta correlacionadas con esa.

Como comenta Javier si no quieres ningún tipo de discriminación tienes que utilizar un sistema experto perfectamente trazable y con criterios bien establecidos, no machine learning. Claro que entonces los beneficios de la optimización se esfuman…

Este problema ya se daba por ejemplo en los seguros de coches sin que hubiese machine learning de por medio, puesto que se sabe que las mujeres generan menos gastos a las aseguradoras. Ahora les toca pagar parte de los gastos de los hombres.

Asier

Exacto. Lo que falta en general en las empresas es estrategia y filtros adaptativos que aprendan del entorno que se mueven ahora, no hace cinco minutos.

Pongo un ejemplo de falta de dinamismo. OFFTOPIC

Se asume que el pacto PSOE/UP le pilla por sorpresa a PP… hace 1 día Teodoro(que le ha barrido VOX en su tierra) asumía que «Sánchez debe irse. No podemos hacerle presidente”. Y ahora dice su jefecito (Master regalado) que “Para este viaje no hacían falta alforjas”

y que se venden a los separatistas. ¿Alguien no ve que es la misma estrategia que ha hecho subir votos a VOX?

Valga la anécdota para ver que una AI no haría otro resultado que el que acabo de describir. Una empresa(o partido) necesita CREATIVIDAD y soluciones laterales, si ahora el Pepito dijera: «No hace falta que busques pactos anti España» te damos una ABSTENCION, y 100 días de Gobierno para ver como reaccionas, te haces el jefe MORAL de la Oposición y les coges con el pie cambiado, le das aire en la «lucha constitucional con los separatistas» y estás INFLUYENDO de verdad en los próximos días y pareces hasta listo, pero como son muy cortos de miras, seguirán en su NO es NO….

Y para los PPeros que no lo ven, solo un presagio, cagarla en 100 días: estos la cagan… y si lo hacen bien, te pones la medalla que es gracias a tu apoyo…

Cuando le das a una empresa(político) herramientas como la AI/BIG DATA, sirve si hay materia gris detrás de quien toma las decisiones… pero no te lo dan todo mascado…

PERDON POR EL OFFTOPIC pero venía al pelo.

Debo ser muy cortito, pero no veo la sufieciente relación entre el texto de la entrada y la orientación de los textos en comentarios. Así que me inhibo. Mi ML sigue demasiado sesgado en sentido humanitario.

Lamento discretar con vd. en este caso, señor Dans: eso de echarle la culpa a la máquina está ya muy visto. Estamos ante un evidente fallo de diseño del que Apple es responsable. El que el susodicho algoritmo, como la mayoría de los algoritmos de ML, actúe como una caja negra no exime de responsabilidad a quien lo ha diseñado y puesto en producción, puesto que su resultado es dañino. Supongo que si un coche autónomo atropella a un peatón no diremos que el fabricante no tiene responsabilidad porque el realmente no quería atropellar a nadie, sino que diremos que puso en la calle una máquina de matar.

Si alimentas con basura un algoritmo de ML obtendrás basura. Apple no actuó con mala fe, pero sí fue negligente al permitir que su algoritmo fuese alimentado con basura. Tal vez alguien dedicó un gran esfuerzo a mejorar las estadísticas del modelo, pero se le olvidó revisar los datos de entrada.

El ML tiene riesgos, si, pero para eso están las compañías de seguros.

Por lo demás, el relato de la respuesta de los servicios de atención al cliente de Apple no tiene desperdicio.

Para un sitio que quedaba libre del tema de las elecciones,… llega un señor que para colmo se llama Abascal a traer a colación el tema.

Los algoritmos, basados en ML o en cualquier otro sistema, se basan en datos o experiencias previas. Si esos datos o experiencias están sesgados, lo estarán los resultados de esos «algoritmos», exactamente igual, que lo están las decisiones que tomamos los humanos basados en esos datos.

¿Acaso no hemos dicho que todos chinos nos parecen iguales? – Pues los sistemas de reconocimiento facial, tendrán graves problemas para reconocer chinos, (salvo que los hagan los chinos, que probablemente digan, que todos los europeos somos iguales).

Si tu fabricas zapatos para señora, harás muy pocos de la talla 42, pues por tu experiencia previa, tienes el «prejuicio», o «experiencia», de que las mujeres tienen el pie más pequeño que los hombres. Si fabricas un «algoritmo» para calcular el número de zapatos de cada talla y lo alimentas de los mismos datos que tu tienes, obtendrás sesgos parecidos.

Siempre habrá una señora de talla de pies 42, que se siente discriminada, porque su marido que tiene el mismo número que ella, encuentra mas zapatos diferentes donde elegir que ella, como siempre habrá un señor de talla 36 de pie, que se quejará de que todos los zapatos que encuentran son de niños.

Aunque las gordas se quejan que no encuentran tallas para ellas en Zara, el tema no es de vital importancia, pero si lo puede ser cuando se trata de diferencias en la concesión de crédito por sexo, raza, o edad, (vete a pedir una hipoteca con 76 años, si quieres observar diferencias a la hora de pedir créditos), o sobre el dinero que se destina a encontrar medicamentos para enfermedades raras.

Realmente, quien pensaba que un «algoritmo» iba a ser mas justo, o menos discriminatorio, que un señor, no sé lo que pensaba que era el «algoritmo»

https://www.enriquedans.com/2019/10/twitter-facebook-y-la-responsabilidad-de-las-plataformas.html#comment-456966

Lee tu comentario, y verás que tu no hablas de política sin venir a cuento

Defendía el derecho de «Unidas Podemos» a hacer publicidad en Facebook, (como estaban haciendolo), porque el tema de post era si se prohibía a los partidos a hacer publicidad en Twitter, algo que a mi modo de ver no es razonable. y es mas, aceptaba como probable la honradez de intenciones de Unidas Podemos en su publicidad.

Creo que decir que «Unidas Podemos» hacía publicidad en Facebook y defender su derecho a hacerlo, venía a cuento en un post que trataba de precisamente de la decisión de Twtter de prohibir la publicidad política en su canal.

El cerebro humano tiene la habilidad de hacer suposiciones con muy pocos datos e incluso plantear situaciones contrafactuales, algo que el ML basado en correlaciones hace realmente mal. Osea, que de momento y para muchos casos, el ‘algoritmo’ y el ‘señor’ toman decisiones de manera completamente distinta, y por tanto sigue siendo necesario complementarlos.

Una empresa que alimenta sus modelos con datos sesgados o con correlaciones espureas, y permite que eso derive en discriminaciones sociales, tiene una responsabilidad al respecto.

Como pocas cosas son muevas bajo el sol, yo hice hace ya montones de años Algo que se llamaba la Red B, un programa que obtenía todos los prestamos que hacia Banesto y todas las empresas participadas de Banesto.

De modo que si comprabas un coche, a plazos, tenías un seguro de vida en tu empresa y utilizabas tarjeta de crédito, Banesto tenia idea de lo que arresgaba contigo,lo que en seguros se llaman cúmulos, o lo que es lo mismo, riesgos que por diversos motivos se producen a la vez, si ocurre un solo suceso.

Por ejemplo si te mueres, a la vez pagaen el seguro de vida, dejas de pagar el coche y los núnmeros rojos de la tarjeta.

Cuando se detecta un cúmulo, se reasegura el riesgo en compañías reaseguradoras, diluyendo el riesgo de pagar por todo a la vez.

Pues bien tambien como teníamos información puntual de los prestamos y pagos al vencimiento se quiso utilizar esta información como «algoritmo» para dar nuevos créditos, pero lo cierto es que nunca se pudo obtener resultados suficientemente fiables, pues es absurdo negar un credito a un señor, porque no paga el recibo de la comunidad hasta que esta arregle la puerta del ascensor, o ha dejado de pagar la luz porque es agosto y no ha dejado fondos en el banco o no paga la letra del coche hasta que le arreglen una avería en garantía.

Por ello, la última palabra para dar un crédito, la tenían los directores de sucursal, que es el que en realidad conoce, (o conocía entonces). al cliente, en prestamos pequeños, (prestamos al consumo, descubiertos,…) y un comité de personas en los grandes, (hipotecas, lineas de descuento a empresas,…) y la información de la Red B se tomaba como un dato complementario mas a tener en cuenta, sólamente,

Por entonces, (1990) aun la banca se fiaba mucho mas del criterio humano que del mecánico, Desconozco si hoy serñá al revés.

PD. Doy fe, que aquel «algoritmo» no tenía en cuenta ni sexo, ni raza, ni edades, solo tenía en cuenta si pagabas con puntualidad tus plazos, hipotecas y pagos domiciliados.

Lo que si pudiera ocurrir es que, si como es normal, la luz, el teléfono, el coche etc, estaban a nombre del marido, la mujer careciera de historial de pagos y eso la pudiera perjudicar, a la hora de pedir un crédito.

Realmente se muy difícil no caer en sesgos diseñando «algoritmos»

No será que el que proporciona los datos es el ser humano errante?

El mal llamado «machine learning», que en realidad es puro ajuste de parámetros, símplemente ajusta la ecuación de una «curva» (multidimensional) a unos datos que le dan. Y luego utiliza esa «curva» para extrapolar nuevos resultados.

Si la «curva» generada pasa por el «punto» que refleja todas las características de este tío, y un límite de crédito alto, y también pasa por otro «punto» que refleja todas las características asociadas a su mujer, y un límite de crédito bajo, esto no tiene NADA QUE VER con la discriminación por sexo.

Las máquinas no discriminan, sino que aprenden de los datos que se utilizan para entrenarlas, y los datos que le han dado para entrenarla son probablemente REALES (porque hay que ser muy bruto para entrenar un algoritmo de aprendizaje automático con datos inventados, o intencionalmente sesgados)

Y probablemente la conclusión de la máquina, NO ESTÉ MAL.

A lo mejor su mujer, en su perfil de gasto habitual se ha mostrado más impulsiva, o usa más la tarjeta a final de mes, cuando hay menos dinero en su cuenta, o tiene unos ingresos menos constantes aunque sean superiores, o vete tú a saber…

Pretender que como él conoce a su mujer, la máquina se equivoca y él no, nos hace sospechar que ella seguramente se la estará pegando con otro, y él no se da ni cuenta..

También se la están pegando a Steve Wozniak entonces :P

Indudablemente la máquina tiene un sesgo asociado a algo común a muchas mujeres, pues hay «el testimonio de otras personas que habían experimentado casos similares».

Pudiera ser como, digo más arriba, que muchas transacciones económicos del matrimonio, se atribuyen al marido y no a los dos. Por ejemplo, él es el que habitualmente paga con su tarjeta la gasolina del coche, o como indico más arriba, gastos de la pareja, como recibos domiciliados del hogar, colegio de los niños, seguros médicos y cosas similares se atribuyen al marido, aunque de hecho lo paguen a medias, compensando por transferencias en dinero entre ellos. Eso daria al marido mayores ingresos , pues tendría los del trabajo y lo que la mujer le ingresa como compensación a los pagos de recibos domiciliados.

Por otra parte, ello puede dar lugar a un mejor historial de pagos del marido que el de la mujer, porque ellas, simplemente, no tenga casi historial de pagos.

Eso puede ser tenido en cuenta a la hora de dar préstamos por el algoritmo, provocando el sesgo..

Lo que trato de argumentar es precisamente que si el conjunto de ejemplos que le han puesto a la máquina para entrenarla demuestran que las mujeres tienen estadísticamente menos fiabilidad al concederles crédito que los hombres, eso sería un HECHO.

Un HECHO, que si la muestra no es intencionalmente sesgada (y no creo que lo sea) es REAL.

El sesgo lo introducimos los humanos cuando, al pensar que ese resultado va a ser percibido como «discriminación por sexo» optamos por elevar «artificialmente» la calificación crediticia de las mujeres para que nadie piense que discriminamos.

Como a las máquinas no les importa lo que piensen de ellas, no introducen esa corrección artificial, que (si la máquina ha aprendido esos resultados a partir de la realidad) iría en contra de la realidad.

Otro problema (distinto) es que algunos algoritmos de aprendizaje automático, y me refiero a las redes neuronales profundas, no pueden «explicar» por qué dan menos crédito a la mujer (en este caso). El resultado de darle menos crédito a la mujer (en este caso) es correcto. Un humano «corregiría» ese resultado, introduciendo un error, para que nadie piense mal de él. La máquina da el resultado correcto, pero no es capaz de explicarlo… y por tanto parece sexista.

El problema no es de estadística, sino de fiabilidad, Si un hombre ha cumplido su acuerdo de pago en 100 ocasiones y una mujer solo en 2, aunque estadísticamente ambos cumplen sus compromisos en el 100% de los casos, el hombre que los ha cumplido muchas más veces que la mujer, parece mas fiable, de ahí el sesgo.

No es el caso porque las mujeres que aparecen en el hilo tienen mejor ‘score’ incluso que sus maridos.

¿Mejor «score» en qué? Puede que eso sea lo que las perjudica.

Desconozco cual ha sido la causa del sesgo en este caso concreto, pero repito, que resulta tremendamente difícil elegir un modelo de datos para las pruebas del «algoritmo», que no produzcan sesgos, porque los datos que introduces pueden ya indirectamente padecer de sesgos, que tu no has querido introducir.

Aunque legalmente hombres y mujeres seamos iguales, eso no es realmente cierto, pues cualquiera puede diferenciar en un grupo de personas quienes son hombres y quienes mujeres y confundirse solo en reducido número de casos. Hombre y mujeres diferimos muchísimo en nuestra actividad diaria, también en la económica. .

Las compras mayoritariamente las deciden las mujeres, son ellas las que se gastan la mayoria de los ingresos familiares. pero determinados productos son mayoritariamente comprados por hombres, y como eso cientos de conceptos relacionados con la economía, (a nombre de quien están las tarjetas de crédito, de que cuenta salen las inversiones en ahorro,….), son específicos de unos o de otros y otros o no lo son que de todo hay.

Esas diferentes formas de actuar son «sesgos» que se reflejan en el bloque de datos que utilizas para hacer la «enseñanza» del «algoritmo»

Según cuenta este hombre, él tenía algunos «pecadillos» en su actividad como emprendedor que su mujer no tenía, pero no me he metido en detalle a leer el tema…

Mejor score crediticio. Que ambos han pagado 50$ cada uno para conocer ese dato y era mejor el de ella. Le ha ocurrido lo mismo a otros que responden en el mismo hilo.

Y yo no sé si utilizan ML o un Sistema Experto, pero en atención al cliente de refieren todo el rato ‘al algoritmo’.

Llevas un tiempo hablando de que los seguros de coches serán más baratos para los buenos conductores, los seguros médicos más caros para los que tienen una vida sedentaria, etc.

¿Qué problema hay ahora con los sesgos de los modelos de aprendizaje?

Por cierto, las personas no tienen género, tienen sexo.

Tercera acepción de RAE género:

3. m. Grupo al que pertenecen los seres humanos de cada sexo, entendido este desde un punto de vista sociocultural en lugar de exclusivamente biológico.

De nada

Efectivamente, desde el punto de vista sociocultural existe hasta el género tonto.

No te lo tomes de forma personal y tan a pecho que un error lo tiene cualquiera. Ya te he sacado del error y con eso me alegro por ti. Y yo contento por haber hecho la buena obra del día contigo.

PRELIMINAR

La explicación de Menestro me cuadra en lo que debe basarse un sistema financiero, ya que aplicar ML a un límite de crédito aporta muy poca inteligencia en un control de riesgos salvo seguir actuando tal y como hasta ahora se venían conociendo

CASO:

Un prominente desarrollador asume que ha habido discriminación debida al uso de un algoritmo

«So let’s recap here: Apple offers a credit card that bases its credit assessment on a black-box algorithm that 6 different reps across Apple and GS have no visibility into. Even several layers of management. An internal investigation. IT’S JUST THE ALGORITHM!»

— DHH (@dhh) November 8, 2019

HIPOTESIS QUE SOSTIENE DHH

Se aplica un ML de clasificación. Pongamos una analogía: clasificar imágenes, si tenemos una BD extensa de animales: podemos detectar perros, gatos, monos, etc y el resultado del ML es que el animal probado será uno con un porcentaje de acierto.

Si volvemos a los créditos. Tendremos x variables de entrada: salario, domicilio, historial de pagados/impagados, saldos en su cuenta. Entrenamos la ML con esos datos y la solución será que aconseja un límite x con un porcentaje de acierto.

¿Qué aporta la ML al problema conceder un límite de crédito? Básicamente nada, salvo seguir con el perfil actual de concesiones… y si puede ser que como variable no deseada estén dentro del perfil raza, género,… pero si se han quitado de la entrada conscientemente hay otras variables que tienen esa información

a) domicilio: la gente se estratifica por barrios según ingresos. Lo de barrios de ricos, pobres, blancos, hspanos, negros,… podemos estar de acuerdo que es real.

b) sexo: lo de la brecha salarial de género no es un invento, es real. A menos ingresos parece obvio que mayor dificultad de devolver un crédito.

INVESTIGACION

«If you have been subjected to discrimination, step forward and email us at consumers@dfs.ny.gov. We also invite experts and members of the tech community to reach out to us at innovation@dfs.ny.gov.»

— Linda Lacewell (@LindaLacewell) November 10, 2019

CONCLUSION

No he visto en ningún comunicado de APPLE o GS que estén usando ML en su APPLECARD

Lo que si hay abierta es una investigación para «hackear» el sistema usado en el límite de riesgo. Para ver si hay discriminación.

Resumiendo al DFS le importa poco si es una ML, o el FICO Score 9, o un tío en Bangalore corriendo una hoja Excel, lo que están comprobando es si HAY O NO HAY DISCRIMINACION DE GENERO…

Muy clara la exposición, gracias

Lo que no concibo es que como ciudadanos aceptemos que una ML se entrometa en decisiones importantes de nuestra vida y no se arme la marimorena !!!

Si el sistema es experto, está claro hay un algoritmo determinista definido por alguien, transparente si se quiere, y las razones por la que no te dan un crédito son las cláusulas A,B,C, D… de ese algoritmo que te hace tener un puntuaje x.

Pero decir que una ML determina por ciencia infusa que tienes un score x, y no saber en que se basa, es lo más mezquino que ha parido madre. No es que te identifique en una foto como un gorila por ser negro ( que ya sabemos como puntua la ML) es que por eggs no te dan crédito, y vas a reclamar, y un asistente que solo lee en una pantalla «NO APTO» te dice que no cumples los requisitos. Preguntas que requisitos y te dicen mus… Deberían estar en el código mercantil o civil estas prácticas con retirada de la licencia como entidad financiera. Que te digan que tienes un historial de impagados, o que es imposible al superar el crédito 6 mensualidades de tu salario, cosas objetivas, no una puñetera caja negra

desde ese punto de vista me parece muy la protesta del desarrollador de SW.

No es un tema trivial. La trazabilidad de un algoritmo cuando a veces eres tú el que le pides que introduzca factores aleatorios para explorar determinados caminos, o que juegue con una barbaridad de variables porque la multicolinearidad ya no es un problema es algo que a menudo sacrifica interpretabilidad a cambio de un mejor poder predictivo. Pero sí, definitivamente es un tema importante, y se lleva cierto tiempo trabajando en ello…

https://en.m.wikipedia.org/wiki/Explainable_artificial_intelligence

Está muy bien que aproveche el altavoz como «friki» de la informática para mostrar su protesta ante una posible discriminación.

Otra cosa, es que pataleo aparte, la Apple Card no deja de ser un producto de gama alta destinada a usuarios de móviles premium, que posiblemente no tendrán problemas para llegar a fin de mes, ni con los límites de crédito, sinó siempre pueden sacar la Visa Platino de su banco tradicional.

Peor es que entres a un centro comercial a comprar un TV de 300 euros y te pidan las ¿3 últimas nóminas? para poder pagarlo a plazos. O que te recaben toda la información personal en un stand de tarjetas para emitir una nueva que te van a conceder «seguro», y finalmente la deniegan, pero los datos se los quedan igualmente.

Veo contradicciones flagrantes en lo de M.L..

Por una parte, (1) se dice, como en los viejos tiempos de la informática tradicional, que ·garbage in, garbage out». Y que por tanto, hay que corregir los datos de entrada (no porque no son reales, sino precisamente porque lo son, puesto que los sesgos están presentes en la realidad.

Pero quien se supone que va a corregir estos datos, si no es modificandolos hasta que coincidan con lo que nos gustaría que fuesen.

(2) Se dice que las L.M. van a proporcionar decisiones más acertadas que las que otros sistemas (automáticos o humanos) podrían hacer. Lo cual me parece contradictorio con el punto anterior.

Además están basadas en estadísticas, las cuales evitan escrupulosamante situarse fuera de las desviaciones típicas y se centran en los modos.

Así que ¿qué Learning Machine sería capaz, alimentada por todos los datos genealógicos-históricos del mundo, de predecir el recién nacimiento de un nuevo Einstein o de un nuevo Hitler?

Creo que ninguna, precisamente porque los algoritmos estadísticos no saben discernir lo excepcional, sino lo más frecuente.

Michel

El problema no es de la ML sino de que está detrás. Como en cualquier otra faceta de la vida se entremezcla mercadotecnia(propaganda) con «ignorancia» de la media de la población. Algo parecido a lo que ocurre con divulgación científica, fenómenos cuarto milenistas etc. Y se confunde por interés a las personas… Pongo un ejemplo

CASO

Tenemos una serie de datos de entrada que relacionan las variables de entrada, X con un conjunto de salida Y

OBJETIVO

A partir de esta info calcular la salida para cualquier valor de la matriz de entrada X

En general supongamos que hay una relación, supongo aquí que lineal, pero puede ser otra o no haberla

Y =A*X,

El objetivo es calcular los parámetros A para que pueda obtener mi salida

TRABAJANDO CON ML

Las personas aplicamos herramientas estadísticas, algebraicas o numéricas para sacar la solución.

De todo ese estudio se va trabajando poco a poco, en algoritmos cada vez más sofisticados que se adaptan a nuestro problema, y por ejemplo en clasificación, dándole un entrenamiento a imágenes, correos, créditos etc, dan unos resultados «optimizados» para ese dataset y algún algoritmo dan salidas con unos porcentajes de éxito elevados.

CONCLUSION

No hay magia, de unos datos de entrada, se saca un resultado. Ni la ML falla como concepto. Ni la ML proporciona ninguna decisión: proporciona resultados. Ni va a descubrir cosas propias de ciencia ficción, ni va a solucionar la vida a una empresa en tomar decisiones, si el manager que hay detrás tiene un CI de mandril. Se acabó la ilusión, el marketing y la magia, SON HERRAMIENTAS PARA NUESTRO USO. Analizar gran cantidad de datos y poder (nosotros) tomar decisiones gracias a que los datos digeridos que facilitan su entendimiento.

Nota: El deep Learning, el argumento es parecido, pero encima hay más ruido, porque la magia aparece ante nuestros ojos, y es más dificil discernir entre correlación y causalidad.

Publicación bien investigada e increíble Best Big Data Analytics service provider in Hyderabad