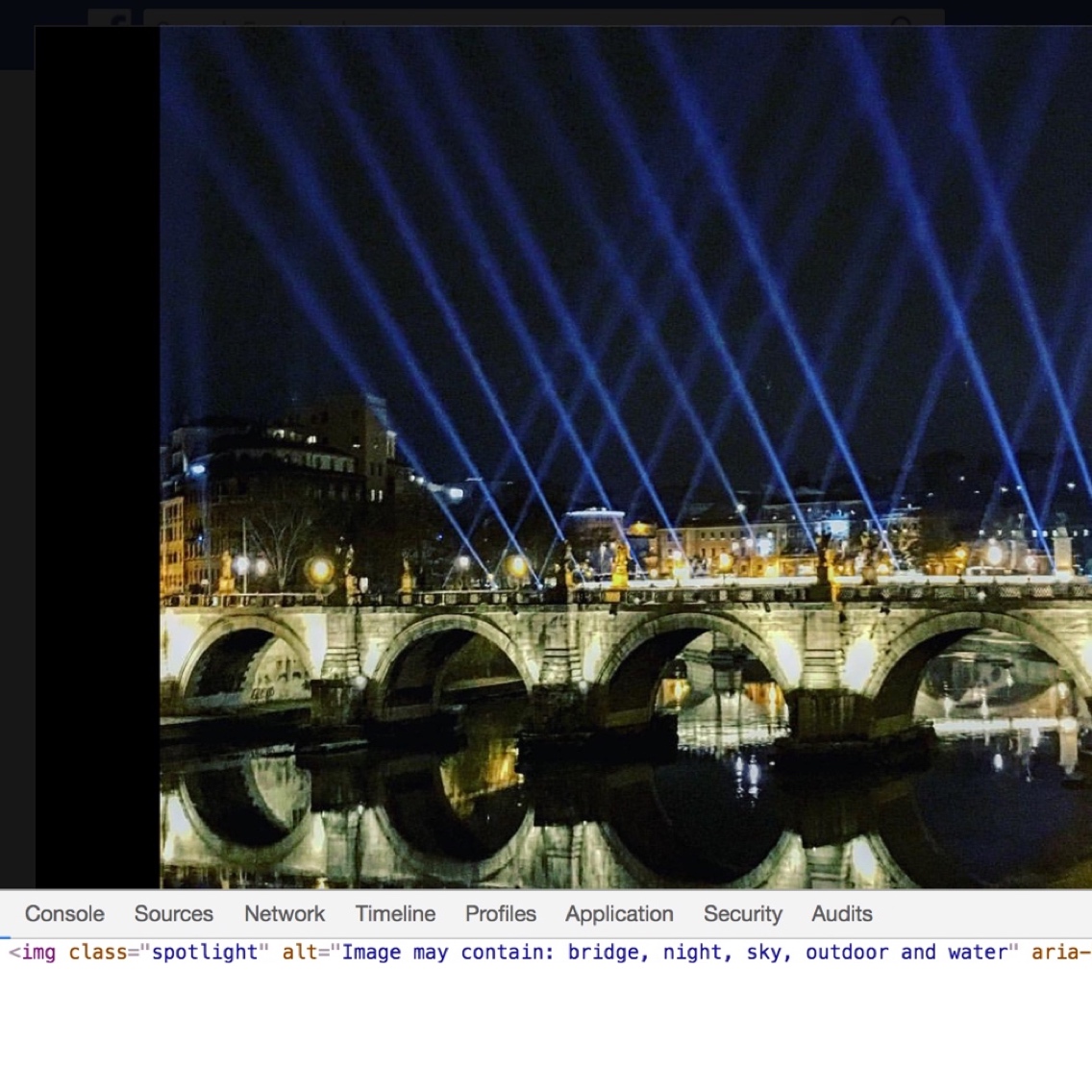

Fíjate en la fotografía que acompaña a esta entrada: una imagen reciente de mi Facebook personal, en la que aparece un puente sobre un río, de noche, con su reflejo en el agua, y unos focos de luz.

Fíjate en la fotografía que acompaña a esta entrada: una imagen reciente de mi Facebook personal, en la que aparece un puente sobre un río, de noche, con su reflejo en el agua, y unos focos de luz.

Hasta aquí, todo normal. Ahora fíjate en la pequeña línea de texto inferior, en la que un algoritmo de inteligencia artificial de Facebook examina la fotografía, la interpreta, la compara con una enorme librería de imágenes utilizada para educarlo, y concluye que las imágenes contenidas en la foto son ni más ni menos que eso: bridge, night, sky, outdoor y water. Un etiquetado perfectamente correcto de la fotografía, realizada de manera completamente automática, sin intervención humana. Algo que también utilizan aplicaciones como Google Photos o Apple Photos para ayudarte a organizar tu librería, ahora aplicado a la presentación pública de fotos en una red social.

Obtener esa descripción para cualquiera de las fotografías que hayas subido a Facebook es muy sencillo. Basta con localizar la foto, ponerla a toda pantalla, hacer clic con el botón derecho para obtener el menú contextual, seleccionar «Inspeccionar» (en Chrome) o «Inspeccionar elemento» (en Firefox), y fijarte en las propiedades Alt asociadas a la imagen. Si no quieres hacerlo así y prefieres una solución que no visualice código, puedes instalar una extensión en tu navegador que las visualiza como una capa adicional sobre las propias fotografías. Facebook lleva desde abril de 2016 añadiendo estas etiquetas a tus imágenes de manera automática, tras un desarrollo orientado a facilitar la usabilidad de la página para personas ciegas o con limitaciones de visión en cuyo desarrollo la compañía empleó unos diez meses.

Cualquier usuario de repositorios fotográficos, comenzando seguramente – o al menos para mí – con Flickr en 2004, recordará los requerimientos derivados del etiquetado de fotografías: escoger etiquetas adecuadas, mantener la coherencia, utilizar singular o plural, etc. para que esas etiquetas pudiesen cumplir su función, la de acceder al contenido de manera más sencilla, cuando fuese necesario. Ahora, un algoritmo puede «ver» la foto, deducir su contenido con un notable índice de acierto, y asignar las correspondientes etiquetas con total corrección y coherencia. Sin intervención humana.

Que una máquina sea capaz de pasar de entender una imagen como un simple conjunto de píxeles, a interpretar su contenido y etiquetarlo con precisión es algo que no es radicalmente novedoso: se lleva mucho tiempo trabajando en ello con un nivel de avance más que notable. Pero constatarlo sobre tus propias fotografías puede ayudar a muchos a entender lo que ello significa y las posibilidades que ofrece. Puede hace que algunos ingenuos que todavía piensan que la inteligencia artificial consiste en la simple ejecución de rutinas preconcebidas se den cuenta de que aquí hay más, mucho más. No hablamos de una máquina capaz simplemente de ver una fotografía y compararla con una base de datos, sino de una máquina que es capaz de ver un puente y ser capaz de entender que es un puente, independientemente del puente que sea o desde qué ángulo esté tomado. Capaz de compararla con todas las fotos etiquetadas como puentes utilizadas en su entrenamiento, y deducir que esa nueva imagen también es un puente… que es básicamente lo que hace una inteligencia humana, tras haber sido adecuadamente entrenada.

This article is also available in English in my Medium page, “When machines understand what they see»

Bueno, la cosa va por buen camino, pero a este algoritmo de Facebook todavía le queda mucho por «aprender».

He estado probando unas cuantas fotos normales, incluyendo paisajes, grupos, cosas, animales….. y no ha pasado de describirlas cómo: «imágen con una o varias personas», y lo demás : «no hay texto alternativo disponible», con lo que creo que todavía falta mucho para tener el scanner de Terminator o del Coche Fantástico ;o)

Curioso, no ha sido esa mi experiencia. A mí me ha identificado fotos contando el número de personas en ellas, viendo si estaban sonriendo, e incluyendo otros elementos de contexto. Sin texto disponible no me ha ocurrido en ninguna, y he calculo que he llegado a mirar unas treinta…

Y si a partir de una imagen o unas cuantas imagenes dicen que las maquinas ya casi pueden escribir una novela, entonces no hay puesto de trabajo que pueda sustituir una máquina de aqui a nada, y entonces que …

Muchas veces nos olvidamos de que las máquinas no «ven» imágenes como nosotros sino unos y ceros. Me parece más milagroso, si cabe, que a partir de esa información se puedan reconocer objetos. Si eso se consigue, se puede hacer cualquier cosa.

Hacen como nosotros? Reconocen patrones. La «inteligencia» viene de comparar esos patrones con la inmensa base de datos que suponen millones de fotos ya etiquetadas.

No es ni inteligente ni milagroso. Intenta hacerlo sin conexión a Internet o a los servidores de comparación y ya verás lo que reconoce. Eso sí es ser inteligente. Esto es simplemente tecnología. La primera máquina de vapor causaba el mismo efecto en los paisanos.

Perdona, Raúl, pero tu interpretación es completamente absurda. Trata de entender lo que ves con la parte de tu cerebro que almacena los recuerdos cercenada, ya verás como no puedes. La parte del cerebro de la máquina que almacena los recuerdos está en la nube, la tuya en tu cabeza… ¿y? ¿Por qué una es mejor que la otra? ¿No te das cuenta de que estás siendo completamente injusto? ¿De qué se trata? ¿De algún tipo de «más difícil todavía»? ¿Para que te parezca a ti bien hay que hacer las cosas sin internet, sin pila, sin cable y sin piedra? Si no podemos utilizar la tecnología disponible para aumentar la memoria hasta el infinito y más allá, o para multiplicar nuestra capacidad y velocidad de procesamiento, porque si lo hacemos entonces a ti te parecerá que «no tiene mérito» y «no es inteligencia», vaya por dios, no vale la pena nada… o simplemente tú estás equivocado.

Perdona Enrique, pero Raúl ha dado en el clavo.

La aplicación clasifica imágenes, no reconoce los elementos que las componen.

El cerebro humano es capaz, además, de reconocer esos elementos aunque no los hayan visto antes, elucubrando sobre su función o sobre las partes o los materiales que los componen.

La inteligencia se despliega tomando decisiones correctas a partir de muy pocos datos. NO EXISTE ningún tipo de inteligencia basada en en el proceso infinitesimal de millones de datos de manera lógica.

Eso es como preguntarle a un reloj qué hora va a ser dentro de una hora ;)

Disculpa pero no es absurda. No es la tuya, punto. Que yo sepa no eres el garante de la verdad.

En MI opinión es tecnología, no inteligencia. Inteligencia PARA MI es ponerte por primera vez delante de una máquina arcade para jugar al Tetris o al Mario y tras 3 o 4 partidas pillarle el truco. Para que la AI haga eso por ahora hacen falta horas de programación y elementos comparadores.

No soy garante de la verdad, pero sí he trabajado con algoritmos de machine learning. Y piensan, vaya si piensan. Mejor que muchos humanos, créeme… Lo que tu llamas «pillarle el truco» lo hacen esos algoritmos en un momentito, y con procedimientos muy similares a los tuyos. Te guste o no, o te parezca que ofende algún tipo de norma escrita, piensan. Y cada vez pensarán mejor.

Respondo sobre mi comentario porque sobre el tuyo no me deja o lo das por zanjado.

Si leemos eso que mandas dice que han tenido varias versiones del software, y ahí radica para mi la clave. Han tenido que meterle horas.

Ahora dale un móvil a un niño de 5 años con esos juegos instalados y cronometra lo que tarda en jugar.

Que la AI acaba por hacerlo mejor y más rápido? Si, con ingenieros programando detrás. Es tecnológicamente maravilloso? Si. Es muy útil? Si. Es eso inteligencia? Pues PARA MI no. Al menos hasta que se redefinan las clases de inteligencia

Pues estoy de acuerdo con Raúl. Eso no puede llamarse «inteligencia». En mi caso particular, desarrollo software desde hace años y puedo decir con propiedad, que un programa, que es lo que tú llamas en este caso » inteligencia «, sin alimentación y retroalimentación externa por parte del programador, aún siendo un programa capaz de retroalimentarse de datos por si solo realizando comparaciones con su bases de datos para encontrar una solución al problema, no es capaz de «entender» como nosotros, el contexto sobre el que se desarrollan las «acciones» del trabajo que realiza; es decir, no entiende la «realidad real» de lo que está sucediendo, ni el alcance, ni las consecuencias de nada. Si llamamos inteligencia al simple hecho de resolver problemas, estamos mal, porque una hormiga puede resolver problemas sencillos dentro de su contexto existencial, mediante soluciones preprogamadas en su ADN, pero la diferencia con la maquina radica en que la hormiga evoluciona, aprende y se adapta, así le tome millones de años, a nuevas circunstancias para poder sobrevivir y lo hace por si misma, aunque no conscientemente, sino mediante la modificación de su ADN y sus patrones de conducta. A las computadoras les faltan, a mí juicio, todavía muuuuuchos años más para ser adaptativas, como las formas de vida biológicas… Saludos y mis respetos ;-)

La máquina usa ceros y unos (si no es «cuántica») para comunicarse, pero lo que ve en su cerebrito es un puente ( la síntesis de un montón de puentes que le «metieron»)… es por eso que un ciego puede llegar a ver en su pantalla cerebral (supuesta en condiciones) si se consigue un medio de trasladar las señales pertinentes… o eso pienso!

Las máquinas sí que están empezando a ver como nosotros. Es decir, se sabía desde hace décadas que nuestra visión consiste en que hay neuronas que detectan la existencia de bordes, y al activarse envían sus señales a otras neuronas que detectan vértices que unen bordes, dando origen a una especie de representación de perfiles que delimitan zonas de diferente color.

Las técnicas actuales de reconocimiento de imágenes por IA están copiando esta manera de funcionar nuestra. Es decir, la visión artificial sí que está haciendo las cosas al estilo de la visión natural.

Ahora bien, no olvidemos que nuestro cerebro consiste en litro y medio de neuronas interconectadas en 3 dimensiones, mientras que un chip consiste en un cuadrado de uno o dos centímetros de lado con sus transistores (mucho más simples que una neurona) interconectados en 2 dimensiones. Eso sí, cada transistor es muchísimo más pequeño y rápido que una neurona.

No creo que haya nada mágico en la inteligencia humana, si seguimos siendo mucho más inteligentes que las máquinas es solo porque tenemos un hard muy superior en nuestro cráneo. Pero como la ley de Moore siga marcando este ritmo exponencial de avance… :-)

Efectivamente, una manera bastante eficaz de demostrar que la accesibilidad no es solo útil para personas ciegas, sino para todas las personas.

Este es mucho mejor:

http://www.orcam.com/

En realidad, la maquina no ve un puente, ni lo reconoce como tal, simplemente le aplica las etiquetas de las imágenes que coinciden con imágenes similares, y el patrón de reconocimiento es un algoritmo que reconoce limites de regiones, tonos y ‘Fingerprints‘ de esas imágenes o «huellas digitales» en imágenes similares.

Eso aumenta la precisión para identificar una imagen. No es estrictamente un reconocimiento visual a nivel ‘semántico’. No sabe lo que es un puente.

Es un truco ‘fotográfico’, por decirlo así, pero funciona muy bien para etiquetar las imágenes.

En la industria de la fotografía digital no se busca un reconocimiento semántico de los objetos, desde los años noventa, sino la capacidad de clasificar las imágenes sin una comprensión visual de la misma.

Es mucho más eficaz que la visión natural de objetos, cuando se trata de identificar los atributos y no solo de interpretar conceptualmente lo que se ve.

Siento ser aguafiestas. Un ojo compuesto de insecto es incluso más sofisticado, aunque no entienda lo que ve.

Pd.

Krigan, te has escapado cuando íbamos a hablar de matemáticas. No huyas.

(compartí dormitorio con un ingeniero de McDonnell Douglas con la máxima puntuación en el SAT)

;-)

Creo que estás confundiendo 2 cosas diferentes, la visión de las cosas, y su conocimiento semántico. Un ciego, aunque no pueda ver, sabe perfectamente qué es un puente. Un pájaro, que sin duda puede ver el puente, es bastante dudoso que sepa qué es.

Actualmente, las máquinas sí ven las cosas, e incluso tienen una limitada capacidad de reconocimiento semántico de lo que ven. Un coche autónomo sí que es capaz no solo de ver que en determinada posición hay algo, sino que además es capaz de detectar que ese algo pertenece a ciertas categorías (por ejemplo, que ese algo es un coche de la policía, o que es un peatón).

Una simple etiqueta (como las de la foto de Enrique) no indica necesariamente un reconocimiento semántico, pero si además de clasificar la máquina sabe que ese objeto tiene ciertas características, y se ha de reaccionar ante él de ciertas formas, eso ya empieza a ser reconocimiento semántico.

Aunque claro, todo depende de si consideramos que una habitación china tiene o no conocimiento semántico.

https://es.wikipedia.org/wiki/Habitación_china

PD: no he escapado de nada. Dijiste una cosa que no era cierta, y te lo señalé. En tu contestación dijiste otra cosa que no era cierta, y también te lo señalé. Para mí, ahí se acaba la historia.

Todo el mundo tiene sus propias filias respecto a medir el uso de las cosas. Veo a diario la temperatura en el móvil, pero para mí eso es menos importante que Google Maps, pese a que lo uso con menos frecuencia. El parámetro medido por Nielsen (usuarios únicos mensuales) me parece adecuado para hacerme una idea de cómo está el tema.

A ver Krigan, lo que dices del sistema de reconocimiento de objetos y obstaculos de los coches autónomos es interesante.

(Pero no te lo tomes como una disputa dialéctica)

Los sistemas de los coches autónomos, reconocen formas y dimensiones. E incluso predicen trayectorias, lo que los convierte en uno de los sistemas más sofisticados para las maquina de uso común.

Pero no pueden saber de que color es la bicicleta o el coche que aparece en su espacio de detección, o identificar su modelo o uso.

Tienen un entendimiento espacial de su «campo de visión» del que precisamente, carecen los algoritmos de reconocimiento de imágenes.

Esa es una de las diferencias entre los sistemas ‘inteligentes’ y la percepción humana y es que, estos están altamente especializados y se limitan a una función muy concreta.

Y podríamos seguir enumerando montones de cosas que, aunque parecen «humanas», son solo un reemplazo funcional adaptado a los sistemas digitales.

Nuestra forma de medir el espacio no es equiparable; la naturaleza no tuvo a bien equiparnos con un sistema láser, sensores ultrasónicos, o un computo algebraico para delimitar distancias.

No somos coches, ni pares ni impares. :-)

–

«Cualquier tecnología suficientemente avanzada es indistinguible de la magia»

Arthur C. Clarke

Sí que tenemos un sistema de cálculo de distancias, nuestro cerebro compara las imágenes obtenidas de ambos ojos, y los tenemos proyectados hacia delante (al igual que los monos y a diferencia de muchos animales) con ese fin. El sistema concreto de visión que se emplee (cámara, lidar, sonar, etc) es irrelevante de cara a debatir sobre la IA. Creo que es legítimo decir que los murciélagos ven con sus orejas. Y los coches autónomos también usan cámaras, no solo el lidar.

El coche de Google es capaz de saber cuándo un coche es de la policía, o es un coche «normal». O cuando un motorista hace una señal con su brazo, indicando que va a girar. No estamos hablando de mero conocimiento espacial.

Un programa de ajedrez no es IA, es un simple tritura-números, aunque gane al mejor jugador del mundo. Pero estos sistemas, de reconocimiento de imagen, conducción autónoma, y otros, sí son IA. Tienen sus diferencias en su funcionamiento interno respecto a nosotros, pero también sus semejanzas.

Y sobre todo, son capaces de aprender de la experiencia. Para mí esa es la definición de inteligencia.

Para que no te parezca tanta magia:

https://devblogs.nvidia.com/parallelforall/deep-learning-nutshell-core-concepts/

Sí Krigan, claro que podemos calcular distancias, y la visión estereoscópica nos permite hacerlo con mayor precisión, pero no mediante operaciones algebraicas discretas, ni de la misma forma que lo hace un computador.

El reconocimiento de gestos es algo habitual, en las cámaras fotográficas, por ejemplo.

Y por supuesto que también se interpretan las señales de tráfico mediante software.

Pero no hay ninguna semejanza entre la forma de hacerlo de los diferentes sensores de un coche autónomo, su procesado posterior, y la forma en que lo hacemos los seres humanos.

La antropomorfización de los objetos inanes, o el animismo, son mecanismos psicológicos con los que hacemos frente a lo desconocido y tratamos de asimilarlo culturalmente.

Es una forma de pensamiento mágico y de integración de la tecnología y la simbología cultural asociada.

Ante algo que no comprendemos, trazamos una similitud o paralelismo con atributos humanos, que nos hacen más familiares esos elementos extraños.

Es algo que nos acompaña desde que empezamos a desarrollar herramientas, arte o representaciones simbólicas del mundo que nos rodea.

Y que se debe tener en cuenta, cuando te dedicas a la tecnología. Su adopción cultural y social.

Y sí, los programas de ajedrez hacen un uso profuso de las técnicas de AI y Deep Learning.

El equívoco, proviene de percibir esa tecnología como algo asimilable a la inteligencia humana. Aunque use la palabra ‘inteligente’ no es sinónimo de ‘Semejante a un ser humano’.

:-)

–

Y evidentemente, hay que divulgar sobre ese tema, sin idealizaciones pseudocientíficas. O nada que venga de la Singularity University, los extropianos o las creencias transhumanistas

Ya pondré los enlaces, que sospecho que habrá ocasión.

No, Menestro, los programas que le ganaron a Kasparov, entonces el mejor jugador de ajedrez del mundo, primero en una partida a media hora por jugador, y pocos años más tarde en un match de 6 partidas en condiciones de torneo (2 horas los 40 primeros movimientos), esos programas NO usaban técnicas de IA.

No deja de ser paradójico que me acuses de pensamiento mágico cuando tú has incurrido en ese vicio. Es decir, que como esos programas ganan al ajedrez, ¡entonces usan IA!

Ya dije que los programas de IA tienen sus diferencias respecto a nosotros en su funcionamiento interno, y también dije que tienen sus semejanzas. Ambas afirmaciones son ciertas. Es igual de irracional el negar cualquiera de las 2.

Por tanto, deberías leer el enlace que te puse. A partir de ahí podrás hablar con conocimiento de causa acerca de si hay o no semejanzas.

No es ninguna acusación, Krigan. Por supuesto que no pretendo herir susceptibilidades.

Estoy dándote una explicación a porque experimentamos sentimientos de simpatía y afecto hacia objetos, o ideas, y les dotamos cualidades que nos son afines a nuestra experiencia.

Somos humanos, y hacemos eso.

Te dejo, que tengo que separar a mi roomba del perro del vecino. Se odian.

;-)

Menestro:

Ya, pero es que yo soy más bien poco dado al pensamiento mágico. La cuestión de si hay semejanzas (además de las diferencias) entre la IA y el funcionamiento de nuestro cerebro es simplemente comparar entre funcionamientos internos. Aunque hay muchas cosas que todavía se ignoran sobre el cerebro, hay algunas otras que sí se saben.

Yo tengo un Neato, que es más inteligente que el Roomba ;-P

Para mi, si lo que hacen las máquinas se puede calificar como inteligencia, como inteligencia artificial o de cualquier otra manera me parece poco relevante. Lo importante (en mi opinión) es si consiguen resultados igual de buenos o mejores que los humanos, para que nos asistan en nuestras tareas o las hagan por nosotros.

¿Piensan y evalúan posiciones los programas de ajedrez como los humanos? Ciertamente no, pueden calcular, pero carecen de «intuición», que sí usan los humanos (sobre todo por falta de tiempo para calcular). ¿Son «inteligentes»? Ciertamente de alguna manera sí, son capaces de evaluar numéricamente posiciones con un montón de variables, hacer las mejores jugadas, y desde hace años son usados por los jugadores profesionales antes y después de las partidas (y hay que vigilar que no los usen durante las mismas).

Entonces si para mejorar la posibilidad de encontrar fotos entre miles una máquina tiene que «verlas» y añadir etiquetas y apple respeta mi intimidad y no mira mis fotos, apple se queda atrás, ofrece un peor servicio y en el futuro esto se puede reflejar en su precio no?

¿O apple si que está trabajando estos temas también?

Un saludo.

Metadata son aquellos datos residuales que han pasado desapercidos en la comunidad tecnológica por muchas décadas, ahora nos damos cuenta del valor que tienen esos datos, cualquier «algoritmo» de los 4 grandes se nutre principalmente por el uso de esos Metadatos, acabamos de comenzar a discubrir el tremendo potencial que tienen, las relaciones entre etiquetados son y serán la base fundamental de cualquier sistema basado en AI , el valor no está en el dato en sí, si no en la potencia de relacionarlo con otras etiquetas, acababamos de comenzar a jugar con el tecnología, os recomiendo la librería tensorflow de Google para entender lo que viene en los próximos 10 años.

¿Y si me saco la foto del puente que me ha hecho el dentista, también me lo etiqueta como «puente»?

Si aquí se cree que lo que vemos es simplemente lo que vemos, y se ignora lo más que complejo de la función de visión, la percepción, etc. y nos creemos el cuento para niños de que las máquinas hacen exactamente lo mismo que los humanos (mejor o peor), apañados vamos… ¡¡¡Pero si hay miles de kilómetros de libros sobre cómo funciona la mente humana dándose de patadas los unos con otros como para que ahora se crea que una máquina hace algo parecido…!!! No, la máquina hace lo que hace, entre otras cosas porque la ha diseñado algo llamado humano, y luego, los llamados humanos hacen cosas que no se pueden comparar con ninguna máquina, aunque suela ocurrir que, según qué criterios se utilicen, dichas máquinas lo hagan mucho mejor que cualquier humano…

En estas cosas, siempre pasa lo mismo: Muchos se dejan fascinar, hipnotizar por la Luna, y no ven el dedo que se la está señalando cuando antes ni se habían dado cuenta de su existencia…

En fin…

Posiblemente te queden años aún para ello, años de encontrarte de narices con evidencias palmarias que te negarás a aceptar una y mil veces, pero en algún momento dejarás esa concepción cuasirreligiosa y te darás cuenta de la gran verdad: que las máquinas son capaces de pensar y de generar conocimiento nuevo desde hace ya algún tiempo, desde que los algoritmos introdujeron componentes creativos. Algunas de las jugadas esgrimidas por AlphaGo para ganar a los mejores jugadores del mundo no habían sido probadas jamás por un humano, y de hecho, sorprendieron muchísimo cuando las hizo. Simplemente, las había obtenido jugando partidas imaginarias contra sí mismo, y había sido capaz de deducir su superioridad, a pesar de que no estaban en el conjunto inicial (enorme) de jugadas que le facilitaron en su entrenamiento. La máquina es capaz de crear caminos nuevos a partir de una variedad de mecanismos, y de ponerlos a prueba contra conjuntos de reglas. La máquina ya hace muchas cosas mucho mejor que un humano, y con el tiempo, esto será cada vez más cierto y referido a cada vez más cosas.

No sé si me replica a mí o a quién, porque si me replica a mí, no lo entiendo, ya que digo que «los llamados humanos hacen cosas que no se pueden comparar con ninguna máquina, aunque suela ocurrir que, según qué criterios se utilicen, dichas máquinas lo hagan mucho mejor que cualquier humano…», yendo mucho más lejos que usted. La verdad, no lo entiendo, pero déjeme decirle que la fascinación que tienen muchos por las máquinas es de aurora boreal, casi en idéntica proporción de la nefasta opinión que algunos de nosotros tenemos sobre los humanos, aunque incluso, algunos les nieguen hasta el hecho de crear esas máquinas ante los que muchos caen rendidos… (Paradoja donde las haya). Saludos.

No entiendo la disputa, Indudablemente la IA no utiliza los mismos métos es lo mismo que la Inteligencia humana, pero lo importante es si se puede utilizar en sustitución de la inteligencia humana.

Veamos.Una calculadora no multiplica utllizando el algoritmo de los humano, pero nadie duda que multiplica y lo hace más deprisa. La rueda no funciona como las piernas, pero nadie duda que el coche anda y lo hace más deprisa. Las alas de un avión no son como las alas de un pájaro pero nadie duda que el avión vuela y lo hace más deprisa. Un submarinos nada debajo del agua , no lo hace como un pez pero nadie duda que navega sumergido y l es capaz de atravesar el polo norte sumergido.

Bien, la IA es capaz de clasificar imágenes y decir esto es un puente y es de noche. Me importa poco como lo haga, lo cierto es que vale para clasificar imágenes, como lo haría un humano y lo hace más deprisa.

¿Lo hace de otra forma? — Desde luego,… ¡Y a quién le importa como lo hace!, lo important es que lo hace y lo hace más deprisa.

La disputa está en lo que se entiende como inteligencia.

A ver si ya lo ha explicado, unos avanzan con ruedas y otros con patas, unos vuelan agitando las alas como los pájaros y otra técnica es el avion … y ahora vienes «la disputa es lo que se entiende por avanzar»

Cuando pensamos en inteligencia, siempre pensamos en lo mismo. Pero ¿qué es la inteligencia?

Tipos de inteligencia

En este caso concreto es clasificar fotografías. Si una persona hiciera ese trabajo, ¿diríamos que realiza un trabajo intelectual o un trabajo manual?

Si ,ya se que no se necesita una inteligencia descomunal para ello, pero si mas o menos, la misma que se necesita para diferenciar un gasto de un pago a proveedores y todos diríamos que un contable realiza un trabajo intelectual.

Exacto.

Nos vamos a enredar sobre si llamarlo «inteligencia», «inteligencia artificial» o de otra manera, pero lo cierto es que:

1) Las máquinas producen conocimiento: esto ya lo hacían los programas de ajedrez («tritura-números» sin IA ni intuición ni creatividad) que descubren jugadas ventajosas y novedosas que no vienen en las enciclopedias de aperturas ni se han jugado nunca en torneos, pero que pueden valer el ganar el campeonato del mundo a tu contrincante.

2) No lo hacen como lo hacemos los humanos (entre otras cosas porque no acabamos de comprender cómo funciona nuestro cerebro)

3) Determinadas tareas las hacen (o harán) mejor o igual que los humanos.

Incluso si lo reducimos a un debate puramente funcional, sigue quedando la cuestión de si la cosa se va a quedar en «determinadas tareas» o bien se llegará a «cualquier tarea».

Hasta hace no tantos años, durante el «invierno de la IA», en la que esta no servía para nada útil, la cosa estaba clara. A los ordenadores se les daban muy bien cosas que no requerían IA, tales como calcular miles de decimales de pi (o trayectorias de sondas espaciales), jugar al ajedrez, y buscar un dato determinado entre millones de registros. Y había otras cosas que se les daban muy mal, como el reconocimiento de imágenes, y en general el reconocimiento de patrones.

Ahora la máquina entiende lo que le dices, sabe que en la foto hay algo llamado «puente», te conduce el coche en autopista, y otras muchas cosas más que se hacen con IA. Ahora los ordenadores ya tienen la potencia necesaria para hacer cosas útiles con IA, y cada vez son más potentes.

¿Hay algo que la IA no pueda hacer?

Si las máquinas entendieran y fueran inteligentes, no estarían al servicio de depredadores humanos sin escrúpulos.

Yo Daniel Blake.

Conozco montones de personas que entienden y son inteligentes, y que están al servicio de depredadores humanos sin escrúpulos.

¿Quién lucha en las guerras? ¿Las máquinas o los hombres?

En la guerra del Golfo (1991), la aviación ya había ganado a todos los efectos prácticos la guerra para cuando se produjo la ofensiva terrestre de la Coalición. El presidente Bush padre mandó detener la ofensiva a las 100 horas justas de su inicio bajo la percepción de que «ya no quedaba nadie con quien combatir».

Unos años más tarde, en la guerra de Kosovo, Serbia se rindió ante la ofensiva aérea de la OTAN sin que fuera necesaria ninguna intervención de fuerzas terrestres. Fue la primera guerra de la Historia ganada exclusivamente mediante el empleo de fuerzas aéreas y misiles de crucero.

Posteriormente, USA ha hecho un uso creciente de aviones sin piloto en diversos conflictos, para reconocimiento y bombardeo.

Tanto los aviones sin piloto como los misiles de crucero son robots militares. Dado que desde Kosovo está claro que la aviación (y los misiles de crucero) puede ganar por sí sola una guerra, y que la aviación cada vez consiste más en ataques con drones, no está lejos el momento en que una guerra te la luchen (y ganen) enteramente las máquinas.

A no ser que por «luchar» entiendas el llenarle el depósito a un dron o el pulsar un botón para cargar un objetivo en la memoria de un misil de crucero.

Si fuese así de sencillo en Afganistán o en Siria se habría acabado el conflicto antes.

Los robots no te valen cuando te cambian el entorno en el que los has programado. A no ser que comulgues con los «daños colaterales».

Ya me gustaría saber cuándo fue la última vez que un piloto USA tuvo una misión sobre esos 2 países. Si te descuidas, igual USA está ya luchando en esas 2 guerras exclusivamente a base de drones.

Os dejo un ejemplo de reconocimiento de imágenes dibujadas a mano hecho por Google:

https://quickdraw.withgoogle.com/

Jejeje. Esa web es una caña.

No se si alguno de vosotros ha realizado mini-tareas para Crowdflower o Amazon Mechanical turk. Alguna de las tareas propuestas consisten en hacer tagging de imagenes, del estilo de que te ponen una foto de la celebracion de una boda y tienes que poner varias palabras que te sugiera esa imagen, como boda, novia, novio, vestido, invitados, salon, ceremonia, etc. Obviamente, cuando hay mucha superficie verde lo interpreta solo como campo o cesped, pero gran parte de la identificacion se hace a mano.

Lee el artículo. Desde abril Facebook lo hace de manera automática.

Hola Enrique,

Lo primero muchas gracias por tu blog y por todo lo que aprendemos contigo.

Respecto al reconocimiento de imágenes yo he alucinado con Google Photos. Si te descargas la aplicación en España, por motivos de privacidad no se activa automáticamente la opción de reconocimiento de caras. Pero si lo haces en EEUU, o lo simulas a través de una VPN, sí que puedes activarlo. Es increíble como crea albums automáticos por persona de todas tus fotos!. Comete algún error, pero alucinas con el gran trabajo que hace.

Por otro lado, lo que es más potente todavía es poder buscar utilizando lógica. Por ejemplo, «Jorge y Fernando y Londres», para encontrar fotos donde salgamos yo y mi hermano del viaje a Londres!. Te animo a que lo pruebes.

Lo que yo echo en falta es que facilitasen más datos, más estadísticas o más funciones a los usuarios. Por ejemplo, si yo quiero saber ¿Quién es la persona que más sale en mis fotos?, debería ser fácil para Google responder una vez que tiene reconocidas las imágenes, sin embargo, no he visto Apps ni APIs que expongan funcionalidades de este tipo.

Saludos, y de nuevo, gracias por tu blog.